의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 1 / 13 BRIC View 2021-T13

의료/ 헬스케어 분야에서의 설명 가능

인공지능(Explainable AI) 연구 동향

한 형 진

가톨릭관동대학교 국제성모병원 피부과학교실E-mail: clemens21@hanmail.net

요약문머신 러닝(machine learning, ML)과 딥 러닝(deep learning, DL) 등의 인공지능(artificial intelligence, AI) 관련 테크닉들은 제4차 산업 혁명의 핵심에 자리잡은 키워드로 인간의 삶에 큰 변화를

일으키고 있다. 특히 자율 주행, 음성 인식, 유튜브 추천 알고리즘 등은 이미 자리를 잡은 지 오래이다. 디지털 혁명의 한가운데에 서 있는 우리로써는 AI에 친숙해지고 매일 변화를 거듭하는 AI에 본질에 대해 이해를 할 필요가 있다. 본 동향리포트에서는 의학 응용 프로그램에 중점을 둔 설명 가능한 AI (explainable artificial intelligence, XAI)가 무엇인지 설명하고 생명과학과 의학 분야에서 이용되고 있는 XAI의 이용 분야에 대하여 대략적으로 살펴보고자 한다.

Key Words: Efficacy, evaluation, human disease, animal model

목 차

1. 서문 2. 본문

2.1. AI 의 설명성(Explainability in artificial intelligence) 2.2. 설명 가능한 AI (eXplainable AI, XAI)

2.3. XAI 의 적용 분야

2.3.1. 급성 심근경색(Acute myocardial infarction, AMI) 2.3.2. 당뇨(Diabetes) 2.3.3. 유방암(Breast cancer) 2.3.4. 코로나바이러스 감염병(COVID-19) 2.3.5. 치매(Dementia) 2.3.6. 신약 개발(Drug discovery) 2.3.7. 임상 유전체학(Clinical genomics) 3. 맺는 말 4. 참고문헌 BRIC View 동향리포트

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 2 / 13

1. 서문

일반적으로 머신 러닝(machine learning, ML)과 딥 러닝(deep learning, DL) 같은 인공지능(artificial intelligence, AI) 기법들은 자율 주행 자동차(self-driving cars) [1], 음성 인식(voice recognition) [2] 등과 같은 다양한 응용 분야에서 매우 인상적인 성능을 보여주었다. ML 기반 프로그램들은 매우 큰 데이터셋을 통해 “교육”을 받은 DL 접근 방식이 시각적 작업, 특히 바둑 게임같은 영역에서 인간의 능력을 초월한다는 것을 보여준 바 있다. 우리는 여러 가지 기술 유형의 융합을 특징으로 하는, "디지털 혁명"으로 알려진 “4차 산업 혁명(the 4th industrial revolution)”이라는 중요한 시점에 와 있다. 제4차 산업혁명의 시기에 활동하는 과학인들인 우리는 AI에 익숙해지고, AI의 현재와 미래의 용도를 이해하고, AI가 임상의학에서 주류로 진입함에 따라 AI와 지식적으로 협력할 수 있도록 준비해야 한다. 본

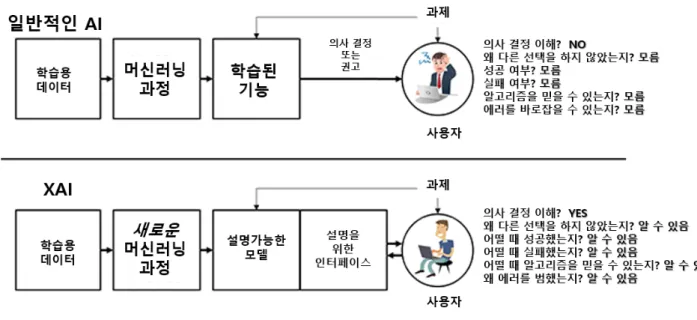

동향리포트에서는 매우 특수한 영역인, 의학 응용 프로그램에 중점을 둔 설명 가능한 AI (explainable artifi-cial intelligence, XAI)를 소개하고 생명과학과 의학 분야에서 이용되고 있는 XAI의 이용 분야에 대하여 대략적으로 살펴보고자 한다. 그림 1. 임상 결정 지원 시스템(CDSS)의 흐름도. 평균 수명 증가, 만성 질환의 급상승, 신기술이지만 고액인 치료법의 지속적인 발달로 인해 현재 전 세계적으로 의료 비용이 큰 폭으로 증가 중이다. 이러한 현 의료상황에서 AI 기반 의료 서비스를 개선하고 보다 비용 효율적인 시스템을 만들어 이용할 경우 의료비 증가를 완화할 수 있을 것으로 기대되고 있다 [3]. AI는 의학에서 현재 조기 질병 발견하고 [4, 5] 질병 진행에 대한 이해를 도우며 [6], 약물 용량을 최적화하고 [7], 새로운 치료법을 발굴에 내는 데에 도움을 주고 있다 [8, 9]. AI의 최대 강점은 방대한 크기를 가진 데이터셋의 신속한 패턴 분석이다. 패턴 인식 활용에 가장 성공한 의학 분야로는 안과 치료, 암 검진, 영상의학 판독 등이 있으며, 여기서 AI 알고리즘(algorithms)은 육안으로 감지할 수 없는 병변이나 미세한 점(예: 초기 흑색종)에 대한 영상

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 3 / 13 이미지 판독에서 경험 많은 임상의보다 나은 결과를 보여주었다 [10, 11]. 표 2는 대표적인 머신러닝 영역에서 대표적인 AI 알고리즘을 정리한 것이다. AI 시스템이 인간 임상의사를 완전히 대체할 가능성은 높지 않지만, 임상 필드에서 의사 결정(decision-making) 부분에서는 큰 도움이 되기 때문에 그 사용이 점점 더 증가하는 추세이다. 인간의 학습 능력은 타고난 지능, 지식에 대한 접근성, 인생 경험 등에 의해 제한되는 반면, AI에 의해 구동되는 컴퓨터 시스템은 병목현상(bottleneck) 없이 사실상 무제한의 의료 및 생물학적 정보를 빠르게 합성, 분석할 수 있기 때문이다. 임상의학에서는 AI의 잠재력을 최대화하기 위해 매우 큰 데이터셋(예로 전자 의무기록, electronic health record 또는 EHR)을 사용하게 되는데, 이를 통해 통상적인 통계 소프트웨어로는 수행하기 힘든 인간의 행동과 패턴에 관한 동향과 연관성을 밝혀낼 수 있다 [12].

임상의학에서 AI 애플리케이션은 종종 임상 결정 지원 시스템(clinical decision support sys-tem, CDSS) 의 형태로 제공되며 (그림 1) [13] 임상의에 의해 행해지는 진단 및 치료 결정 과정을 돕게 된다. 기존의 CDSS가 개별 환자의 특성과 기존 지식 기반의 특성과 일치하는 경우 AI 기반 CDSS는 사용 사례와 일치하는 환자의 데이터에 대해 학습된 AI 모델을 적용하게 된다 [14]. 그러나 엄청난 잠재력에도 불구하고, AI는 아직 완벽한 해결책이 되지 못하고 있는데, 가장 중요한 이유 중 하나는 바로 “설명성의 부재”라고 할 수 있을 것이다. 표 1. AI 알고리즘의 분류.

회귀(Regression) 분류(Classification) 군집화(Clustering)

Learning type 지도 학습(supervised) 지도 학습(supervised) 비지도 학습(unsupervised)

출력물 연속 변수 범주형 변수 데이터 포인트를 군집화

주 목표 예측 데이터의 카테고리 분류 비슷한 아이템끼리 군집화

예 주식 시장 예측 스팸 이메일 분류 “사기성” 거래 판별

알고리즘 선형 회귀 로지스틱 회귀 K-mean

2. 본문

2.1. AI의 설명성(Explainability in artificial intelligence)

오늘날의 임상의사의 진단적/치료적 의사 결정을 지원하는 AI 시스템의 주요한 문제점 중 하나는 진단 및 치료에 직간접적으로 관련된 사람들-즉, 의사, 환자, 연구원 등-이 충분히 이해할 수 있는, 이른바 설명성(explainability)의 부재라고 할 수 있다. 설명 가능성(explainability)의 문제는 사실 AI 만큼 오래되었고, AI가 존재하기 시작한 때부터 필연적으로 발생할 수밖에 없는 이슈라고 볼 수도 있다 [15]. AI 중심적인 접근 방식은 많고 다양한 응용 분야에서 최근 놀라운 성능을 보여주지만, 여전히 그것의 결정을 이해할 수 있는 방법으로 "설명"할 수 없기 때문에 그 효과는 제한적일 수밖에 없었다. 우리가 기본적인 수학 이론을 이해한다고 해도 모델이 어떤 원리/논리로 작동하는지에 대한 통찰력을 얻고 결과가 어떻게, 왜 달성 되었는지를 설명하는 것은 복잡하고 사실

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 4 / 13

거의 불가능에 가까운 문제라 할 수 있다. 본질적으로, “설명성(explainability)”이란 특정 AI가 제시한 예측에 대하여 타당한 이유를 재구성할 수 있는 AI 기반 시스템의 특성으로 설명할 수 있다.

설명성은 일반적으로 3가지 단계가 존재하는데 보통 모델링 전 설명성(pre-modelling explainability), 설명 가능한 모델링(explainable modelling), 모델링 후 설명성(post-modelling explainability)으로 분류한다 (표 2) [16, 17]. 여기서 주목해야 할 중요한 점은 AI의 설명성을 설명하기에는 많은 측면이 고려되어야 하며, 설명성이란 개념이 정의하기가 쉽지 않다는 점이다. “해석성” 또는 “투명성”과 같은 다른 용어는 종종 설명성과 같은 개념으로 사용된다. 임상에서 전문의의 의사결정을 돕기 위해서는 학습된 표현의 인과관계를 이해하는 것이 필수이기 때문에 설명성은 의학에서 특히 중요하다고 할 수 있다. 표 2. AI 설명성의 3단계 (3 Stages of AI explainability). Pre-modelling explainability Explainable Modelling Post-modelling explainability

Goals Understand/describe data

used to develop models

Develop inherently more explaina-ble models

Extract explanations to describe pre-developed models

Methodologies

Exploratory data analysis

Adopt explainable model family Perturbation mechanism Dataset description

standardization

Hybrid models Backward propagation

Dataset summarization Joint prediction and explanation Proxy models Explainable feature

engineering

Architectural adjustments and regularization

Activation optimization

2.2. 설명 가능한 AI (eXplainable AI, XAI)

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 5 / 13 전통적인 통계 분석에 기반한 고전적 분석 모델과 달리 기계 학습(ML) 방법을 사용하여 구축된 복잡한 모델은 사용자에게 결정을 설명하고 정당화하기가 더 어려울 수 있다. 그리하여 최근에는 “설명 가능한 인공 지능(XAI)”이라고 불리는 ML 시스템의 설명성에 관한 연구가 증가하고 있다 [18]. “XAI 시스템”이란 쉽게 말해서 "무엇을", "언제", "어디서", "누가" 같은 질문에 더 많은 신뢰도를 부여할 수 있는 모델을 지칭한다. XAI는 AI 시스템에 의해 만들어진 권고가 높은 정확성 및 정당성을 보유해야 하는, 의학 및 보건의료 분야에서 특히 중요한 역할을 하며, 의료종사자가 더 나은 진단적/ 치료적 의사 결정을 내리고 새로운 지식, 통찰력 또는 발견을 할 수 있도록 도움을 주는 것이다. XAI 알고리즘은 투명성, 해석성 및 설명성의 세 가지 원칙을 따르는 것으로 보통 설명된다 (그림 2) [19, 20]. ML 모델이 별도의 인터페이스 없이 자체적으로 이해할 수 있는 가능성을 보이는 경우 투명성(transparency)을 가진다고 지칭한다 [21]. 즉, 시스템에 별도로 추가된 구성 요소가 없이도 학습 모델을 본질적으로 이해할 수 있는 경우 투명한 모델이라고 하는 것이다. 한편 해석성(interpretability)은 설명성과 달리 사용자가 모델을 이해할 수 있는 ML 학습 모델의 수동적인 기능이라 할 수 있다. 그리고 설명성은 모델이 수행한 프로세스를 명확하게 설명할 수 있는 학습 모델의 기능으로, 설명성의 목표는 학습 모델의 내부 작업(inner working mechanism)을 명확히 이해할 수 있도록 하는 데에 있다 (그림 3). 부정확한 예측은 중대한 결과를 초래할 수 있기 때문에 투명성과 설명가능성은 실제 임상에서 AI 모델을 광범위하게 도입하는 데 절대적으로 필요한 것이다. 임상의는 예측을 신뢰할 수 있고 AI 모델이 잠재적으로 부정확한 예측을 할 수 있는 개별 사례를 식별할 수 있도록 AI 모델의 근본적인 추론을 이해할 수 있어야 한다. 따라서 유용한 설명은 예측을 유도하는 AI 모델에서 관련 부분을 설명할 수 있는 능력뿐만 아니라 임상의의 인과적 이해를 이해할 수 있는 방법으로 이 관련성을 제시할 수 있는 능력도 포함한다. XAI는 현재 신경과학 및 행동 과학 [22], 유전체학(genomics) [23], 유방암, 만성질환 [24] 등 광범위한

생의학(biomedicine) 및 보건의료(public health)의 여러 분야에서 광범위하게 응용되고 있으며 대표적인 예를 몇 가지 들어보고자 한다.

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 6 / 13

2.3. XAI의 적용 분야

2.3.1. 급성 심근경색(Acute myocardial infarction, AMI)

급성심근경색(acute myocardial infarction, AMI)은 흔히 혈압과 심박수 등의 활력 징후(vital signs)로 이루어진 매개 변수들의 악화가 선행한다는 것이 일반적인 특징이다. 초기 임상 예측은 일반적으로 조기 경고 점수(early warning scores, EWS)와 같은 선별 지표에 기초한다. EWS의 예측 성능은 대개 민감성과 특수성 사이의 적절한 절충이기 때문에 이따금 환자에게 매우 부정적인 결과로 이어질 수 있다. EHR 데이터로 훈련된 AI 시스템에 대한 이전 연구는 AMI의 초기 실시간 예측과 관련하여 높은 예측 성능(high predictability)을 보인 바 있다. 그러나 의사 결정에 대한 근거를 충분히 설명할 시스템이 없다면 그 임상적 사용 가치는 제한적일 수 밖에 없다. 덴마크의 한 심장내과 그룹에서는 AMI의 조기발견을 위한 XAI 조기경보점수(xAI-EWS) 시스템을 발표하였다 [25]. XAI-EWS는 이를 설명하는 EHR 데이터에 대한 정보를 곁들여 예측을 수행, 결과적으로 임상적인 효용 가치를 높이게 되었다. 이들의 시스템은 수정된 EWS (modified EWS, MEWS)와 순차적 장기 기능 상실 평가 점수(sequential organ failure assessment, SOFA) [26] 등 기존의 조기경보 점수(EWS) 시스템보다 더 먼저, 그리고 더 정확히 AMI의을 예측할 수 있었다고 보고하였다. 이들이 개발한 XAI-EWS 시스템의 핵심은 xAI-EWS가 주어진 예측에 대해 간단한 시각적 설명을 제공하도록 설계되었다는 점이다. 결론적으로 이들의 시스템은 높은 예측력을 유지하면서, AI의 결정을 EHR 데이터에 근거하여 심장내과 임상의들에게 성공적으로 설명할 수 있었다는 데에 그 의미가 있다.

2.3.2. 당뇨(Diabetes)

당뇨(diabetes mellitus, DM) 환자는 주요 실명 원인 중 하나인 당뇨병성 망막병증(diabetic retinopathy, DR) 발병 위험이 높은데, 조기 발견과 적절한 치료로 환자들은 실명을 피할 수 있다. 네덜란드의 한 안과 연구진 [27]은 망막 기저부(retinal fundus)의 이미지를 입력 데이터로 사용하고 DR을 정의하는 모든 종류의 병변을 검출하는 컴퓨터 보조 검출 시스템을 소개하였다. 이들의 시스템의 목적은 건강한 망막을 자동으로 감지하고 병이 진행되고 있는 망막의 이미지를 선별해 냄으로써 안과 전문의들을 돕는 것이다. 후자의 경우, 이 시스템은 의심스럽다고 표시한 국소 병변을 안과의와 함께 검사할 수 있는 대화형 도구(user-system interface)를 제공하며, 최종 결정은 안과 전문의가 내리게 되는 시스템이다. 이들의 알고리즘은 모든 후보 DR 정의 병변을 찾고 인식할 수 있는 다중 클래스 검출기로 구성된다. 시스템이 하나 이상의 병변을 감지하면 문제가 있는 병변으로 표시된다. 병변을 검출하는 시스템은 매우 빠른 “R-CNN ResNet [28, 29]”이라는 아키텍쳐(architecture)로 구축되어 있으며, 이 아키텍처는 개발자들이 사전 학습을 통해 교육한 것이다. 개발자들은 정상 소견 이미지와 병변이 존재하는 이미지의, 이항 분류(binary classification) 를 바탕으로 민감도(sensitivity)와 특이도(specificity)를 측정하여 Messidor-2와 IDRiD와 같은

벤치마크 데이터셋에 대한 접근방식을 평가하였는데 Messidor-2와 IDRiD [30]에 대해 얻은 결과는 각각 민감도 0.965, 0.830, 특이도 0.843, 0.940였다고 한다. 이러한 높은 병변 예측도 외에도, 이 시스템의 또 다른 중요한 특징은 사용자와 시스템 사이의 상호소통적 인터페이스로, 시스템에 의해 감지된 모든 의심스러운 병변을 선별하여 사용자에게 보고하고 이에 대해 “토론” 할 수 있다는 것이다.

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 7 / 13

2.3.3. 유방암(Breast cancer)

사례 기반 추론(case-based reasoning, CBR)은 쿼리(query, 질의)에 대한 해법이 이전에 알려진 사례를 모아놓은 데이터베이스를 사용하여 답과 함께 사용자에게 제공하는 유사성 추론(analogous reasoning)의 한 형태이다 (그림 4) [31]. 쿼리와 유사한 사례들을 데이터베이스에서 검색하여, 그 해결책들을 쿼리에 적용시키는 것이다. 그러나 이러한 설명 가능성은 충분히 설명되지 못할 뿐 아니라, 대부분의 CBR 시스템에서 제공하는 설명은 유사한 사례의 제시에 그치는 경우가 대부분이다. 프랑스의 한 유방외과 연구팀 [32]은 자동적으로 알고리즘이 실행되어 사용자 인터페이스(user interface)에 쿼리에 대한 답이 자동으로 제시되는 CBR 방법을 제안하였다. 유사한 사례를 검색한 후, 시각적 인터페이스는 질의와 유사한 사례 사이의 양적, 질적 유사점을 표시하여 시각적 추론을 통해 유사점과 차이점을 설명할 수 있다. 이 연구팀은 유방암 진단에 이 방법을 적용하여 이 방법이 κ-nearest neighbors (κNN) [33]와 같은 지도 학습 알고리즘(supervised learning algorithm)에 필적하는 분류 정확도를 보일 뿐만 아니라 설명가능성 또한 더 우수하다는 것을 보여주었다. 그림 4. 사례 기반 추론법(case-based reasoning, CBR). 2.3.4. 코로나바이러스 감염병(COVID-19) 코로나바이러스병(COVID-19)은 기침, 발열, 심한 경우 폐렴 등의 증상과 함께 호흡기 질환을 일으키는 것이 주요한 증상이다. 인체에서 코로나바이러스를 감지하는 검사는 가래나 혈액 샘플을

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 8 / 13

채취하여 수행하며 그 판정 결과는 일반적으로 수 시간 또는 길게는 수일 내에 나오게 된다. 또한 환자의 흉부 방사선 영상 분석(x-ray) 결과 폐렴(pneumonia)의 양상을 보이는 것이 특징이다. Brunese 등 [34]은 다기관에서 추출한 6,523개의 흉부 X선에 대한 실험 분석 결과 COVID-19 검출에 대한 평균 시간 약 2.5초, 평균 정확도 0.9의 훌륭한 예측성능을 보고하였다. 또한 Singh 등 [35]은 흉부 X-Ray를 사용하여 COVID -19 환자를 신속하게 분류할 수 있는 새로운 DL 기반 프로그램을 소개하였는데, 이들의 시스템은 표준 데이터셋에서 3가지 군, 즉. COVID-19 군, 정상군, 폐렴 군으로 나누어 테스트를 시행한 결과 각각 98.67%의 정확도(accuracy), 0.98의 κ-계수(Cohen’s kappa)를 보여 기존 방법을 크게 능가한다고

발표하였으며 임상에서 COVID-19 환자 평가의 중요한 요소로 사용될 수 있음을 주장하였다. 2.3.5. 치매(Dementia) 치매 진단을 위해 신경과 전문의는 환자의 인지력을 평가하고, 치매에 대한 바이오마커(biomarkers)를 찾기 위해 뇌 영상 데이터를 간단히 분석하는 과정을 보통 거치게 된다. 이 중, 바이오마커를 찾는 과정은 분석과 해석에 큰 어려움이 따르기 마련이다. AI 모델은 영상자료 평가에서 임상의를 도와 이러한 난관을 극복할 수 있다는 가능성을 보여준 바 있다. 그럼에도 불구하고, 지금까지 개발된 대부분의 모델은 명확한 설명가능성없이 예측을 발표하는 블랙박스(black-box) 시스템인 경우가 많아 실제 적용에 제약이 많았던 것이 사실이다 (그림 5). 스위스의 한 연구팀 [36]은 뇌 3차원(3-D) MRI T1 증강 촬영영상을 통해 학습한 DL 시스템을 소개하였다. 모델이 훈련을 받으면 치매의 자동 진단뿐만 아니라 치매 발생에 근원이 되는 뇌의 부분을 증강시키는 열 지도(heat map)를 만들어 낼 수 있다고 하였다. 이들은 MRI 촬영 영상을 통해 ML이 치매 환자를 식별하는 동시에 모델이 의사 결정에 대한 해석을 또한 완벽히 제공할 수 있다는 것을 보여주었다. 각 환자의 뇌에 중첩된 맞춤형 "설명기(explainer)" 뷰어를 포함한 이러한 AI 도구들은 완성도와 신뢰도가 더 높은 ML 기반 진단 시스템 개발로 이어질 것이며 컴퓨터 지원 진단(computer-assisted diagnostics)에 대한 필드 임상의들의 신뢰를 두텁게 할 것으로 기대된다. 또한, 현재 알려지지 않은 치매의 바이오마커들을 발견하는 데 도움이 될 것이고 따라서 질병에 대한 이해도를 높이는 데에도 기여할 것이다. 그림 5. 블랙 박스 모델(black-box model).

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 9 / 13

2.3.6. 신약 개발(Drug discovery)

지난 수 년간 동안 AI의 다양한 개념들이 컴퓨터를 이용한 신약 발견에 성공적으로 이용된 바 있다. 이러한 발전은 주로 다중 처리 레이어를 가진 인공신경망(artificial neural network, ANN)과 같은 DL 알고리즘의 능력-즉 복잡한 비선형 입출력 관계를 모델링하고, 낮은 수준의 데이터를 가지고 패턴 인식과 특징 추출을 수행하는 능력에 기인하는 것이었다 [37]. DL은 분자 설계, 화학 합성, 단백질 구조 예측, 고분자 표적 식별과 같은 고급 작업을 가능하게 한 원동력이다. 최근에는 화학·헬스케어 분야에서 신경망이 등장하면서 관심이 또다시 높아지고 있다. 특정 ML 모델의 해석성 부족을 완화하고, 인간의 추론과 의사결정을 강화하기 위한 노력의 일환으로 XAI 접근방식에 관심이 모아지고 있다. 신약을 설계하는 것은 특정 분자구조로부터 약리학적 기능을 추론할 수 있는지, 그리고 그 분자구조 중에서도 어떤 특이 요소들이 기능과 가장 관련이 있는지를 탐구하는 과정이다 [38]. XAI는 약학 화학자(pharmaco-chemists), 화학 정보학자(chemical informaticians) 및 데이터 사이언티스트(data scientists) 간의 협력을 촉진할 것이다. 실제로 XAI는 이미 약물 작용의 기계론적 해석을 가능케 하는 원동력일 뿐 아니라 유기적 합성 계획과 약물 안전성 강화에도 기여하고 있다. 장기적으로, XAI는 인간의 바이어스(bias)를 피하면서 점점 더 복잡해지는 화학 데이터의 분석과 해석뿐만 아니라 새로운 약리학적 가설의 형성에 근본적인 동력을 제공할 것이다. 2.3.7. 임상 유전체학(Clinical genomics) DL 알고리즘은 종래의 접근법에 비해 예측 성능을 크게 향상 시켜 여러 분야의 데이터 과학에 혁명을 일으켰다. 최근 XAI가 순수 예측력 향상을 넘어 새로운 연구 영역으로 떠오르고 있다. 독일의 한 연구팀 [39]은 Genome-wide associations study (GWAS)에서 표현형의 유전적 구조에 대한 설명성을 연구하였다. 유전체 구조의 각 위치를 개별적으로 시험하는 대신에 “DeepCOMBI” 라고 불리는 새로운 알고리즘을 이용하였는데, 우선 피험자를 각각의 표현형으로 분류하기 위한 신경망을 훈련시킨 후 다중 가설 검사(multiple hypothesis testing) [40]에서 가장 관련성이 높은 위치를 결정하는 데 사용된다. 검증력(power) 및 정밀도(precision) 측면에서, DeepCOMBI은 다른 표준적 방법을 능가하는 것으로 나타났다. 이 연구의 결과로 두 가지 새로운 질병 연관성(고혈압의 경우 rs10889923, 제1형 당뇨병의 경우 rs4769283)이 확인되었다.

3. 맺는 말

이 동향리포트에서 살펴보았듯이, 설명성이 임상필드의 최종 사용자의 결정에 미치는 영향을 분석하는 연구는 일반적인 긍정적 결과를 보여주었다. AI는 이미 우리 경제의 핵심 기술 중

하나이며, AI는 이전 산업 혁명에서 증기기관(steam engine) 이나 전기(electricity)가 가져온 것과 유사한 변화를 의료계에서 일으킬 것이 분명하다. 그러나 인간의 AI에 대한 통제력 상실에 대한 우려와 AI가 의료 환경에서 의사 결정에 어느 정도까지 영향을 미칠 수 있는지에 대한 질문이 큰 과제로 대두되었다. 어떤 경우에서건, AI가 내린 의사 결정이 어떻게 이루어졌는지를 인간

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 10 / 13 사용자에게 이해시키고, 또 사용자는 그 설명의 질을 평가하는 것이 필요할 것이다. 아직 해결되지 못한 설명성의 문제를 극복하기 위해서는 해당 임상과의 최신 지견, 응용 수학(applied mathematics), 데이터 과학(data science) 등을 통합된 특수한 전문 교육이 필요해 보인다. XAI가 나아가야 할 미래의 방향 중 한 가지는 의사 결정 과정에서 의료 데이터와 환자의 기록과 같은 여러 가지 양식을 함께 사용하고 모델 결정을 각자에게 귀속시키는 것이다. 이것은 환자의 기록과 물리적 파라미터를 모두 사용하여 결정을 내리는 임상의사의 진단 알고리즘과 사실 유사하다. 이것은 잠재적으로 정확성을 향상시킬 수 있을 뿐만 아니라 나타나는 현상을 보다 포괄적으로 설명할 수 있다. XAI가 여러가지 방면에서 크게 발전하고 있기는 하지만 최종 사용자, 규제 기관 및 일반 대중의 기대에 부응하기 위해서는 아직 가야할 길이 멀다.

4. 참고문헌

[1] Poon NC, Sung JJ. Self-driving cars and AI-assisted endoscopy: Who should take the responsibility when things go wrong? J Gastroenterol Hepatol. 2019 Apr;34(4):625-626. doi: 10.1111/jgh.14641. PMID: 30920688.

[2] Kuo YC, Rosen S, Faulkner A. Acoustic cues to tonal contrasts in Mandarin: implications for cochlear im-plants. J Acoust Soc Am. 2008 May;123(5):2815. doi: 10.1121/1.2896755. PMID: 18529197.

[3] Hlatky MA, Kazi DS. PCSK9 Inhibitors: Economics and Policy. J Am Coll Cardiol. 2017 Nov 28;70(21):2677-2687. doi: 10.1016/j.jacc.2017.10.001. PMID: 29169476.

[4] Magesh PR, Myloth RD, Tom RJ. An Explainable Machine Learning Model for Early Detection of Parkinson's Disease using LIME on DaTSCAN Imagery. Comput Biol Med. 2020 Nov;126:104041. doi:

10.1016/j.compbiomed.2020.104041. Epub 2020 Oct 8. PMID: 33074113.

[5] Jo YY, Cho Y, Lee SY, Kwon JM, Kim KH, Jeon KH, Cho S, Park J, Oh BH. Explainable artificial intelligence to detect atrial fibrillation using electrocardiogram. Int J Cardiol. 2020 Dec 1:S0167-5273(20)34222-4. doi: 10.1016/j.ijcard.2020.11.053. Epub ahead of print. PMID: 33271204.

[6] Fellous JM, Sapiro G, Rossi A, Mayberg H, Ferrante M. Explainable Artificial Intelligence for Neuroscience: Behavioral Neurostimulation. Front Neurosci. 2019 Dec 13;13:1346. doi: 10.3389/fnins.2019.01346. PMID: 31920509; PMCID: PMC6923732.

[7] Romm EL, Tsigelny IF. Artificial Intelligence in Drug Treatment. Annu Rev Pharmacol Toxicol. 2020 Jan 6;60:353-369. doi: 10.1146/annurev-pharmtox-010919-023746. Epub 2019 Jul 26. PMID: 31348869.

[8] Díaz Ó, Dalton JAR, Giraldo J. Artificial Intelligence: A Novel Approach for Drug Discovery. Trends Pharmacol Sci. 2019 Aug;40(8):550-551. doi: 10.1016/j.tips.2019.06.005. Epub 2019 Jul 3. PMID: 31279568.

[9] Kanza S, Frey JG. A new wave of innovation in Semantic web tools for drug discovery. Expert Opin Drug Discov. 2019 May;14(5):433-444. doi: 10.1080/17460441.2019.1586880. Epub 2019 Mar 19. PMID: 30884989. [10] Du-Harpur X, Watt FM, Luscombe NM, Lynch MD. What is AI? Applications of artificial intelligence to

der-matology. Br J Dermatol. 2020 Sep;183(3):423-430. doi: 10.1111/bjd.18880. Epub 2020 Mar 29. PMID: 31960407; PMCID: PMC7497072.

[11] Armengol E. Classification of melanomas in situ using knowledge discovery with explained case-based rea-soning. Artif Intell Med. 2011 Feb;51(2):93-105. doi: 10.1016/j.artmed.2010.09.001. Epub 2010 Nov 12. PMID: 21074978.

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 11 / 13 [12] Bučková B, Brunovský M, Bareš M, Hlinka J. Predicting Sex From EEG: Validity and Generalizability of

Deep-Learning-Based Interpretable Classifier. Front Neurosci. 2020 Oct 27;14:589303. doi:

10.3389/fnins.2020.589303. PMID: 33192274; PMCID: PMC7652844. [13] Shaffer B. The holmium:YAG laser in knee arthroscopy. Operative Techniques in Sports Medicine. 1998;6(3):147-153

[13] Rho MJ, Park J, Moon HW, Lee C, Nam S, Kim D, Kim CS, Jeon SS, Kang M, Lee JY. Dr. Answer AI for pros-tate cancer: Clinical outcome prediction model and service. PLoS One. 2020 Aug 5;15(8):e0236553. doi: 10.1371/journal.pone.0236553. PMID: 32756597; PMCID: PMC7406030.

[14] van Baalen S, Boon M, Verhoef P. From clinical decision support to clinical reasoning support systems. J Eval Clin Pract. 2021 Feb 7. doi: 10.1111/jep.13541. Epub ahead of print. PMID: 33554432.

[15] A. Barredo Arrieta, N. Díaz-Rodríguez, J. Del Ser, A. Bennetot, S. Tabik, A. Barbado, et al.

Explainable artificial intelligence (xai): Concepts, taxonomies, opportunities and challenges toward respon-sible AI. Inform Fusion, 58 (2020), pp. 82-115

[16] Holzinger A, Langs G, Denk H, Zatloukal K, Müller H. Causability and explainability of artificial intelligence in medicine. Wiley Interdiscip Rev Data Min Knowl Discov. 2019 Jul-Aug;9(4):e1312. doi: 10.1002/widm.1312. Epub 2019 Apr 2. PMID: 32089788; PMCID: PMC7017860.

[17] Amann J, Blasimme A, Vayena E, Frey D, Madai VI; Precise4Q consortium. Explainability for artificial intelli-gence in healthcare: a multidisciplinary perspective. BMC Med Inform Decis Mak. 2020 Nov 30;20(1):310. doi: 10.1186/s12911-020-01332-6. PMID: 33256715; PMCID: PMC7706019. [18] Molladavoodi S, McMor-ran J, Gregory D. Mechanobiology of annulus fibrosus and nucleus pulposus cells in inter-vertebral discs. Cell Tissue Res. 2020 Mar;379(3):429-444. doi: 10.1007/s00441-019-03136-1. Epub 2019 Dec 17. PMID: 31844969.

[18] Fellous JM, Sapiro G, Rossi A, Mayberg H, Ferrante M. Explainable Artificial Intelligence for Neuroscience: Behavioral Neurostimulation. Front Neurosci. 2019 Dec 13;13:1346. doi: 10.3389/fnins.2019.01346. PMID: 31920509; PMCID: PMC6923732.

[19] Taylor JET, Taylor GW. Artificial cognition: How experimental psychology can help generate explainable arti-ficial intelligence. Psychon Bull Rev. 2020 Nov 6. doi: 10.3758/s13423-020-01825-5. Epub ahead of print. PMID: 33159244.

[20] Che H, Duan Y. On the Logical Design of a Prototypical Data Lake System for Biological Resources. Front Bioeng Biotechnol. 2020 Sep 29;8:553904. doi: 10.3389/fbioe.2020.553904. PMID: 33117777; PMCID: PMC7552915.

[21] Holzinger A, Carrington A, Müller H. Measuring the Quality of Explanations: The System Causability Scale (SCS): Comparing Human and Machine Explanations. Kunstliche Intell (Oldenbourg). 2020;34(2):193-198. doi: 10.1007/s13218-020-00636-z. Epub 2020 Jan 21. PMID: 32549653; PMCID: PMC7271052.

[22] Chen K, Hwu T, Kashyap HJ, Krichmar JL, Stewart K, Xing J, Zou X. Neurorobots as a Means Toward Neu-roethology and Explainable AI. Front Neurorobot. 2020 Oct 19;14:570308. doi: 10.3389/fnbot.2020.570308. PMID: 33192435; PMCID: PMC7604467.

[23] Reimand J, Isserlin R, Voisin V, Kucera M, Tannus-Lopes C, Rostamianfar A, Wadi L, Meyer M, Wong J, Xu C, Merico D, Bader GD. Pathway enrichment analysis and visualization of omics data using g:Profiler, GSEA, Cytoscape and EnrichmentMap. Nat Protoc. 2019 Feb;14(2):482-517. doi: 10.1038/s41596-018-0103-9. PMID: 30664679; PMCID: PMC6607905.

[24] Gordon L, Grantcharov T, Rudzicz F. Explainable Artificial Intelligence for Safe Intraoperative Decision Sup-port. JAMA Surg. 2019 Nov 1;154(11):1064-1065. doi: 10.1001/jamasurg.2019.2821. PMID: 31509185.

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 12 / 13 [25] Lauritsen, S.M., Kristensen, M., Olsen, M.V. et al. Explainable artificial intelligence model to predict acute

critical illness from electronic health records. Nat Commun 11, 3852 (2020).

https://doi.org/10.1038/s41467-020-17431-x

[26] Soussi S, Taccori M, De Tymowski C, Depret F, Chaussard M, Fratani A, Jully M, Cupaciu A, Ferry A, Ben-yamina M, Serror K, Boccara D, Chaouat M, Mimoun M, Cattan P, Zagdanski AM, Anstey J, Mebazaa A, Legrand M; PRONOBURN group. Risk Factors for Acute Mesenteric Ischemia in Critically Ill Burns Patients-A Matched Case-Control Study. Shock. 2019 Feb;51(2):153-160. doi: 10.1097/SHK.0000000000001140. PMID: 29561390.

[27] Kind A Azzopardi G An explainable AI-based computer aided detection system for diabetic retinopathy using retinal fundus images. in: Vento M Percannella G Computer analysis of images and patterns. Springer International Publishing, Cham2019: 457-468

[28] Zhang R, Cheng C, Zhao X, Li X. Multiscale Mask R-CNN-Based Lung Tumor Detection Using PET Imaging. Mol Imaging. 2019 Jan-Dec;18:1536012119863531. doi: 10.1177/1536012119863531. PMID: 31364467; PMCID: PMC6669841.

[29] Zhang Y, Chan S, Park VY, Chang KT, Mehta S, Kim MJ, Combs FJ, Chang P, Chow D, Parajuli R, Mehta RS, Lin CY, Chien SH, Chen JH, Su MY. Automatic Detection and Segmentation of Breast Cancer on MRI Using Mask R-CNN Trained on Non-Fat-Sat Images and Tested on Fat-Sat Images. Acad Radiol. 2020 Dec 11:S1076-6332(20)30676-0. doi: 10.1016/j.acra.2020.12.001. Epub ahead of print. PMID: 33317911.

[30] Porwal P, Pachade S, Kokare M, Deshmukh G, Son J, Bae W, Liu L, Wang J, Liu X, Gao L, Wu T, Xiao J, Wang F, Yin B, Wang Y, Danala G, He L, Choi YH, Lee YC, Jung SH, Li Z, Sui X, Wu J, Li X, Zhou T, Toth J, Baran A, Kori A, Chennamsetty SS, Safwan M, Alex V, Lyu X, Cheng L, Chu Q, Li P, Ji X, Zhang S, Shen Y, Dai L, Saha O, Sathish R, Melo T, Araújo T, Harangi B, Sheng B, Fang R, Sheet D, Hajdu A, Zheng Y, Mendonça AM, Zhang S, Campilho A, Zheng B, Shen D, Giancardo L, Quellec G, Mériaudeau F. IDRiD: Diabetic Retinopathy - Segmentation and Grading Challenge. Med Image Anal. 2020 Jan;59:101561. doi:

10.1016/j.media.2019.101561. Epub 2019 Oct 3. PMID: 31671320.

[31] Sheng Y, Zhang J, Wang C, Yin FF, Wu QJ, Ge Y. Incorporating Case-Based Reasoning for Radiation Therapy Knowledge Modeling: A Pelvic Case Study. Technol Cancer Res Treat. 2019 Jan 1;18:1533033819874788. doi: 10.1177/1533033819874788. PMID: 31510886; PMCID: PMC6743195.

[32] Lamy JB, Sekar B, Guezennec G, Bouaud J, Séroussi B. Explainable artificial intelligence for breast cancer: A visual case-based reasoning approach. Artif Intell Med. 2019 Mar;94:42-53. doi:

10.1016/j.artmed.2019.01.001. Epub 2019 Jan 14. PMID: 30871682.

[33] Wang C, Long Y, Li W, Dai W, Xie S, Liu Y, Zhang Y, Liu M, Tian Y, Li Q, Duan Y. Exploratory study on classi-fication of lung cancer subtypes through a combined K-nearest neighbor classifier in breathomics. Sci Rep. 2020 Apr 3;10(1):5880. doi: 10.1038/s41598-020-62803-4. PMID: 32246031; PMCID: PMC7125212.

[34] Brunese L, Mercaldo F, Reginelli A, Santone A. Explainable Deep Learning for Pulmonary Disease and Coronavirus COVID-19 Detection from X-rays. Comput Methods Programs Biomed. 2020 Nov;196:105608. doi: 10.1016/j.cmpb.2020.105608. Epub 2020 Jun 20. PMID: 32599338; PMCID: PMC7831868.

[35] Singh RK, Pandey R, Babu RN. COVIDScreen: explainable deep learning framework for differential diagnosis of COVID-19 using chest X-rays. Neural Comput Appl. 2021 Jan 8:1-22. doi: 10.1007/s00521-020-05636-6. Epub ahead of print. PMID: 33437132; PMCID: PMC7791540.

[36] Gallay C, Draganski B, Kherif F. Explainable deep learning models for dementia identification via magnetic resonance imaging Alzheimer’s Dement. 2020;16(Suppl. 5):e047636.

의료/ 헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향 한형진 Page 13 / 13 [37] Yang X, Wang Y, Byrne R, Schneider G, Yang S. Concepts of Artificial Intelligence for Computer-Assisted

Drug Discovery. Chem Rev. 2019 Sep 25;119(18):10520-10594. doi: 10.1021/acs.chemrev.8b00728. Epub 2019 Jul 11. PMID: 31294972.

[38] Brown N, Cambruzzi J, Cox PJ, Davies M, Dunbar J, Plumbley D, Sellwood MA, Sim A, Williams-Jones BI, Zwierzyna M, Sheppard DW. Big Data in Drug Discovery. Prog Med Chem. 2018;57(1):277-356. doi: 10.1016/bs.pmch.2017.12.003. Epub 2018 Feb 24. PMID: 29680150.

[39] DeepCOMBI: Explainable artificial intelligence for the analysis and discovery in genome-wide association studiesBettina Mieth, Alexandre Rozier, Juan Antonio Rodriguez, Marina M.-C. Höhne, Nico Görnitz, Klaus-Robert MüllerbioRxiv 2020.11.06.371542; doi: https://doi.org/10.1101/2020.11.06.371542

[40] Diz AP, Carvajal-Rodríguez A, Skibinski DO. Multiple hypothesis testing in proteomics: a strategy for exper-imental work. Mol Cell Proteomics. 2011 Mar;10(3):M110.004374. doi: 10.1074/mcp.M110.004374. PMID: 21364085; PMCID: PMC3047155.

The views and opinions expressed by its writers do not necessarily reflect those of the Biological Research Information Center.

한형진(2021). 의료/헬스케어 분야에서의 설명 가능 인공지능(Explainable AI) 연구 동향. BRIC View 2021-T13 Available from https://www.ibric.org/myboard/read.php?Board=report&id=3751 (Mar. 30, 2021) Email: member@ibric.org