머리말

본 책자는

CERN LHC

를 활용한

4

대 실험 중의 하나인

ALICE

실험을 위한

컴퓨팅 프레임워크인

AliEn

에 대한 기술 분석 보고서입니다 한국과학기술정보

.

연구원은

2009

년도부터 공식적인

ALICE

컴퓨팅을 위한

Tier2

센터를 구축

‧

운

영하고 있으며 본 보고서는 이 기능의 강화 및 향후 적극적인 지원을 위해 집

필하게 되었습니다 이 책자를 통해 향후

.

ALICE

실험에 참여하는 국내외 연구

자들에게 도움이 될 수 있기를 기원합니다.

이 책자를 만들어내기까지 도움을 주신 모든 분들께 감사드립니다.

년

월

일

2009

11

15

작 성 자

:

김 법 균

(KISTI)

유 진 승 (KISTI)

윤 희 준 (KISTI)

권 석 면 (KISTI)

Christophe Bonnaud (KISTI)

박 형 우 (KISTI)

장 행 진 (KISTI)

제목 차례

Glossary ··· 1 컴퓨팅의 와 서비스 ALICE VOBOX LCG Ⅰ ··· 4 실험에서 활용되는 서비스 개요 1. ALICE WLCG ··· 4 2. gLite-VOBOX ··· 4 3. gLite-WMS ··· 13 와 컴퓨팅 4. CREAM-CE ALICE ··· 16 에서의 실험 5. CREAM-CE ALICE ··· 19 컴퓨팅 관련 주요 데이터 팜 현황 분석 ALICE Ⅱ ··· 20 1. SUBATECH ··· 20 2. TORINO ··· 23 로컬 서비스 AliEn Ⅲ ··· 31 1. AliEn Model ··· 31 2. AliEn Installation ··· 323. AliEn Site Services ··· 34

설정 및 가동 4. aliend ··· 37

AliEn Site Services' detail Ⅳ ··· 40 1. ClusterMonitor ··· 40 2. PackMan ··· 41 3. CE ··· 42 4. Monalisa ··· 46 5. SE ··· 47

6. FTD ··· 47

서비스 및 AliEn Central Dashboard Ⅴ ··· 48

1. AliEn Central Services ··· 48

2. ALICE Dashboard ··· 52 3. Dashboard in Production ··· 54 MonALISA Ⅵ ··· 60 개요 1. ··· 60 소프트웨어 컴포넌트 및 컴포넌트간 연결 2. MonALISA ··· 60 3. AliEn MonALISA ··· 63 4. Automatic Actions ··· 71 5. Site Monitoring ··· 74

그림 차례

그림 1 AliEn LDAP에 등록된 gLite-WMS 리스트··· 14

그림 2 WMS를 활용한 Job Submission 스크립트··· 14 그림 3 LDAP에서의 CREAM-CE 설정··· 18 그림 4 SubaTech 위치··· 20 그림 5 프랑스 내 LCG 및 ALICE 사이트 현황··· 21 그림 6 SubaTech의 LCG 서비스 및 하드웨어··· 21 그림 7 SubaTech의 네트워크 구성··· 22 그림 8 Torino의 SAN 구성··· 24 그림 9 Torino Tier2 ··· 25

그림 10 Torino-CREAM의 Active Jobs ··· 25

그림 11 VOBOX의 로그 파일 분석··· 26

그림 12 Monalisa에서의 스토리지 서비스 상태··· 28

그림 13 DPM-xrootd의 구성··· 29

그림 14 AliEn의 Job Submission Model ··· 31

그림 15 AliEn와 LCG 서비스··· 31

그림 16 AliEn 설치 예··· 32

그림 17 MonALISA에서의 AliEn 상태··· 33

그림 18 VOBOX 내 컴포넌트 들··· 34

그림 19 ALICE LDAP에 등록된 ALICE사용자··· 35

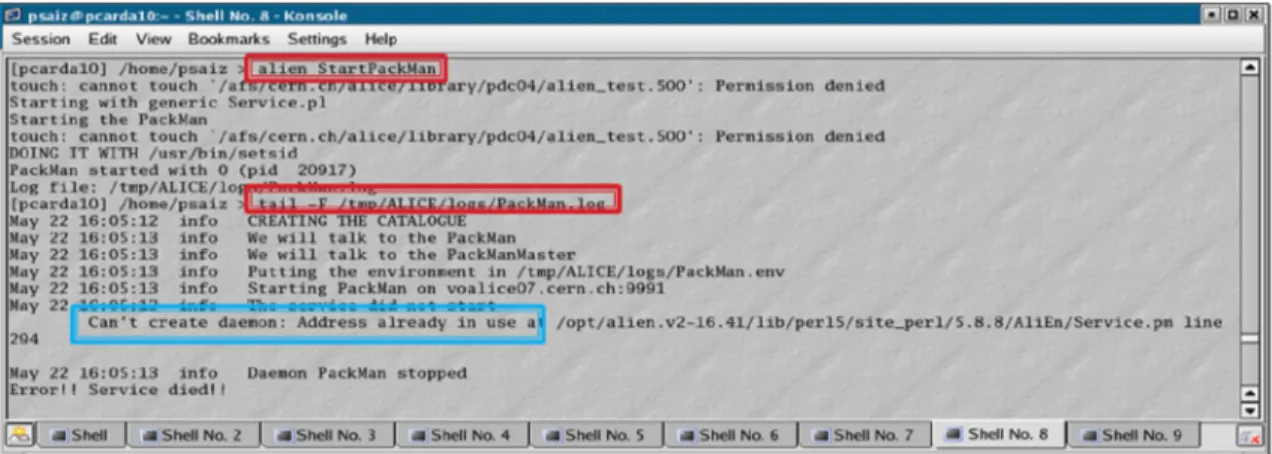

그림 20 AliEn 로그인 에러 사례) LDAP에 대한 사이트 미등록··· 35 그림 21 AliEn 로그인 에러 사례 프록시 없음 에러) ··· 36 그림 22 AliEn 로그인 에러 사례) LDAP에 대한 사용자 미등록··· 36 그림 23 AliEn 로그인 에러 사례 정상적인 로그인) ··· 37 그림 24 AliEn 로컬 서비스 시작··· 38 그림 25 Packman 로그 파일 확인··· 38 그림 26 AliEn 서비스 에러 사례) Packman 포트 중복··· 39 그림 27 ClusterMonitor의 가동··· 40

그림 28 AliEn 서비스 에러 사례) Packman의 LDAP 에러··· 41

그림 30 LDAP에 등록된 CE ··· 43

그림 31 AliEn 서비스 에러 사례) CE가 다운됨··· 44

그림 32 AliEn 서비스 에러 사례) LDAP 등록 에러··· 44

그림 33 AliEn 서비스 에러 사례 큐 닫힘) ··· 45

그림 34 AliEn 서비스 에러 사례) ClassAd Mismatch #1 ··· 45

그림 35 AliEn 서비스 에러 사례) ClassAd Mismatch #2 ··· 46

그림 36 AliEn 서비스를 위한 CERN의 하드웨어··· 48

그림 37 AliEn 서비스와 이를 위한 하드웨어들··· 49

그림 38 DNS Load Balancing ··· 50

그림 39 AliEn Central Services -- Information Service ··· 51

그림 40 AliEn Central Services -- Build Servers ··· 51

그림 41 AliEn Central Services -- Monitoring ··· 52

그림 42 AliEn Central Services -- Other Services ··· 52

그림 43 ALICE Dashboard Framework ··· 54

그림 44 ALICE Dashboard Activities ··· 55

그림 45 ALICE Dashboard 첫 화면··· 55

그림 46 ALICE Dashboard Job Summary ··· 56

그림 47 ALICE Dashboard Job 세부 뷰··· 57

그림 48 ALICE Dashboard FTS Reliability ··· 57

그림 49 ALICE Dashboard SAM Visualization ··· 58

그림 50 ALICE Dashboard Site Availability ··· 59

그림 51 CMS Dashboard Site Status Board ··· 60

그림 52 MonALISA의 Layered Architecture ··· 61

그림 53 Subscriber 및 notification paradigm ··· 62

그림 54 MonALISA의 데이터 모델··· 63

그림 55 MonALISA GUI Client ··· 64

그림 56 MonALISA 기반 AliEn 모니터링··· 65

그림 57 ALICE MonALISA -- Google Maps 활용 GUI 모니터링··· 66

그림 58 ALICE MonALISA -- 사이트별 Active Job 모니터링··· 67

그림 59 ALICE MonALISA -- Site Overview ··· 68

그림 60 ALICE MonALISA -- VOBOXes ··· 68

그림 61 ALICE MonALISA -- VOBOX AliEn Service Status ··· 69

그림 63 ALICE MonALISA -- SAM Tests ··· 70

그림 64 ALICE MonALISA -- SE Overview ··· 70

그림 65 ALICE MonALISA -- SE 상세 뷰··· 71

그림 66 ALICE MonALISA -- Bandwidth Test ··· 72

그림 67 ALICE MonALISA -- Automatic Action ··· 73

그림 68 ALICE MonALISA -- RSS 서비스··· 74

Glossary

□ AFS : Andrew File System

□ ALICE : A Large Ion Collider Experiment □ AliEn : ALICE Environment

□ API : Application Programming Interface □ BDII : Berkeley Database Information Index □ CASTOR : CERN Advanced STORage manager □ CE : Computing Element

□ CERN : European Laboratory for Particle Physics □ ClassAd : Classified advertisement (Condor)

□ CLI : Command Line Interface

□ CNAF : INFN's National Center for Telematics and Informatics □ CREAM : Computing Resource Execution And Management □ dcap : dCache Access Protocol

□ DIT : Directory Information Tree (LDAP) □ DLI : Data Location Interface

□ DN : Distinguished Name □ EDG : European DataGrid □ EDT : European DataTAG

□ EGEE : Enabling Grids for E-sciencE □ ESM : Experiment Software Manager □ FCR : Freedom of Choice for Resources □ FNAL : Fermi National Accelerator Laboratory □ FTS : File Transfer Service

□ GFAL : Grid File Access Library □ GG : Grid Gate (aka gatekeeper)

□ GGF : Global Grid Forum (now called OGF) □ GGUS : Global Grid User Support

□ GIIS : Grid Index Information Server

□ GOC : Grid Operations Centre

□ GRAM : Grid Resource Allocation Manager □ GRIS : Grid Resource Information Service □ GSI : Grid Security Infrastructure

□ gsidcap : GSI-enabled version of the dCache Access Protocol

□ gsirfio : GSI-enabled version of the Remote File Input/Output protocol □ GUI : Graphical User Interface

□ GUID : Grid Unique ID

□ HSM : Hierarchical Storage Manager □ ICE : Interface to CREAM Environment □ ID : Identifier

□ INFN : Istituto Nazionale di Fisica Nucleare □ IS : Information Service

□ JDL : Job Description Language

□ kdcap : Kerberos-enabled version of the dCache Access Protocol □ LAN : Local Area Network

□ LB : Logging and Bookkeeping Service □ LDAP : Lightweight Directory Access Protocol □ LFC : LCG File Catalogue

□ LFN : Logical File Name □ LHC : Large Hadron Collider □ LCG : LHC Computing Grid □ LRC : Local Replica Catalogue

□ LRMS : Local Resource Management System □ LSF : Load Sharing Facility

□ MDS : Monitoring and Discovery Service □ MPI : Message Passing Interface

□ MSS : Mass Storage System □ NS : Network Server

□ OGF : Open Grid Forum (formerly called GGF) □ OS : Operating System

□ PBS : Portable Batch System □ PFN : Physical File name

□ PID : Process IDentifier

□ POOL : Pool of Persistent Objects for LHC □ PPS : Pre-Production Service

□ RAL : Rutherford Appleton Laboratory □ RB : Resource Broker

□ RFIO : Remote File Input/Output

□ R-GMA : Relational Grid Monitoring Archictecture □ RLI : Replica Location Index

□ RLS : Replica Location Service □ RM : Replica Manager

□ RMC : Replica Metadata Catalogue □ RMS : Replica Management System □ ROC : Regional Operations Centre □ ROS : Replica Optimization Service □ SAM : Service Availability Monitoring

□ SASL : Simple Authorization & Security Layer (LDAP) □ SE : Storage Element

□ SFN : Site File Name

□ SMP : Symmetric Multi Processor □ SN : Subject Name

□ SRM : Storage Resource Manager □ SURL : Storage URL

□ TURL : Transport URL □ UI : User Interface

□ URI : Uniform Resource Identifier □ URL : Uniform Resource Locator □ UUID : Universal Unique ID □ VDT : Virtual Data Toolkit □ VO : Virtual Organization

□ WLCG : Worldwide LHC Computing Grid □ WMS : Workload Management System □ WN : Worker Node

컴퓨팅의

와

서비스

ALICE

VOBOX

LCG

Ⅰ

1.

ALICE

실험에서 활용되는

WLCG

서비스 개요

□ gLite-VOBOX, gLite-WMS, CREAM-CE의 공통점 ○ 모두 WLCG/EGEE 서비스임

○ 모두 WLCG/EGEE에 의해 개발 테스트 배포 및 관리가 이루어짐, , ○ 한 사이트에서 제공하는 CREAM-CE와 gLite-WMS는 VOBOX가 관리함

– 이 모든 서비스들은 일반적인 그리드 미들웨어임 – 즉 특정 실험에서 관리하는 것이 아님, – 각 사이트 관리자의 관리 책임임

2. gLite-VOBOX

개요

(1)

○ 다음 기능을 지원하기 위해 2006년에 개발된 WLCG 서비스임 – VOBOX 자체 서비스 실행 – 실험 소프트웨어 영역에 대한 파일 시스템 엑세스 제공 ○ VOBOX 자체는 4대 LHC 실험과는 무관함 – VOBOX의 관리 책임은 사이트 관리자에게 있음 – ALICE는 모든 T0/T1/T2 사이트에 표준 WLCG VOBOX를 사용함와

(2) ALICE

VOBOX

□ ALICE와 VOBOX의 관계 ○ 모든 T0/T1/T2 사이트에 설치된 VOBOX는 ALICE에 자원 제공을 위한 것임 – 프로덕션 레벨 서비스를 위해 필요함 – 모든 표준 LCG 서비스에 필요함 – LCG 환경의 접근 창구 (Entry door)임 – 표준 LCG 컴포넌트를 실행하며 ALICE에 특화된 서비스가 추가됨다른 실험도 마찬가지 ( ) ○ 일관성 있는 배포 – 프로덕션 레벨의 T1과 T2에서 모두 동일한 동작을 함 – 다른 점은 QoS 뿐임 ○ 사이트에 관련된 문제는 사이트 관리자 자체적으로 해결해야 함 □ ALICE VOBOX 요구조건 ○ WLCG Configuration – VOBOX는 WLCG의 통합을 위해 사용됨 – WLCG-UI 기능을 완벽하게 구현 제공함/ ○ ALICE Configuration

– VOBOX Security and Operations Questionaires v-0.5 참조 – 설치 이전에 모든 사이트 관리자에게 배포되어 있음 ○ 전체 프로덕션 지원 – 지역 전문가가 VOBOX를 직접 관리 – 중앙 서비스는 CERN에 위치 □ WLCG VOBOX ○ WLCG 서비스 중 가장 가벼운 서비스에 해당됨

○ VOBOX에 등록된 유저 프록시의 renew 기능을 포함한 gLite-UI임 – 각 실험 서비스의 원활한 동작을 지원하기 위함 – VOBOX에 로그인하는 것이 프록시의 renew를 의미하지는 않음 – 사용자의 프록시를 VOBOX에 renewal을 목적으로 등록해야 함 ○ 파일 시스템 차원의 실험 소프트웨어 영역에 대한 직접적인 엑세스를 제공함 – 따라서 이 노드에 대한 접근은 관리자 권한 소유자로 제한, ○ 방금 설명된 사항들은 ALICE 서비스 차원이 아니며 서비스 자체의 특성임

설치

(3) VOBOX

□ 개괄적인 설치 과정 ○ 설치 참고 자료 – https://twiki.cern.ch/twiki/bin/view/LCG/GenericInstallGuide310 – 64bit 설치 : http://alien.cern.ch/twiki/bin/view/AliEn/HowToInstall64BitVOBox– ALICE의 경우 VOBOX와 WN은 동일한 소프트웨어 패스를 가져야 함 ○ 노드 설정 전 – 호스트 인증서 설치 ○ 노드 설정 후, – VOBOX내 프록시, renewal 서비스가 반드시 동작하고 있어야 함 ․ /etc/rc.d/init.d/<vo_name>-box-proxyrenewal – 엑세스 데몬 또한 동작 중이어야 함 ․ /etc/rc.d/init.d/gsisshd □ 64bit VOBOX ○ http://alien.cern.ch/twiki/bin/view/AliEn/HowToInstall64BitVOBox ○ VOBOX 자체는 64bit 노드와 완벽하게 호환됨 ○ gLite-UI submission 관련 이슈 – 다른 gLite 서비스의 설치 및 설정 가이드 참조 – gLite-UI 패키지 설치 ․ http://glite.web.cern.ch/glite/packages/R3.1/deployment/glite-UI/glite-UI.asp – VOBOX가 /etc/profile/grid-env.sh를 참조하도록 설정 □ VOBOX의 registry 등록

○ CERN의 myproxy 서버에 VOBOX를 등록

– 이렇게 함으로써, VOBOX는 refresh된 유저 프록시를 myproxy서버로부터 다운로드 받을 수 있는 채널을 확보함 – myproxy 서버는 유저가 아니라 노드를 신뢰함 ․ 예를 들어, vobox01.sdfarm.kr은 유저 의A refresh된 프록시를 로부터 다운로드 받을 수 잇는 안전한 채널을 확보함 myproxy ․ myproxy는 이러한 권한을 유저 에게 부여하는 것이 아니라A vobox에게 부여하며 유저 는 이를, A vobox에게 위임하는 형태임

○ 새로 만든 VOBOX의 DN을 Patricia Lorenzo에게 알림 – Subject of the HOST certificate & Hostname

․ /etc/grid-security/hostcert.pem – subject를 보고 싶다면,

$ openssl x509 -text -in /etc/grid-security/hostcert.pem Certificate:

Data:

Version: 3 (0x2)

Serial Number: 312 (0x138)

Signature Algorithm: sha1WithRSAEncryption

Issuer: C=KR, O=KISTI, O=GRID, CN=KISTI Grid Certificate Authority Validity

의 프록시 관리

(4) VOBOX

□ VOBOX의 내부 프록시 관리 ○ Proxy renewal mechanism

– 반드시 /etc/rc.d/init.d/<vo_name>-bin-proxyrenewal이 동작하고 있어야 함 ․ 로그 : /opt/vobox/<vo_name>/log/events.log

– 유저 프록시가 아닌 호스트 프록시를 renew하고 이것이 유저 프록시의 로 이어짐

renew

○ User proxy registration

– 유저 프록시가 등록될 때, VOBOX는 최조의 유저 프록시의 delegation을 수행함 ․ 즉 사용자가 자신의 프록시를 등록할 수 있음에도 불구하고, proxy 가 다운되어 있을 수 있음 renewal service □ 프록시 체크사항 : 사용자

○ User proxy upload into myproxy.cern.ch – Plain proxy

– Operation performed into the gLite-UI

– 프록시가 renewal될 때, VOBOX로 다운로드 될 프록시임 ○ Login user proxy

– It must be voms aware

– Proxy created into the gLite-UI (via voms-proxy-init) – Used to access the VOBOX ONLY

– It is not used for any ALICE service or job submissions ․ Useful for some service debug (i.e., WMS testing) – 이 프록시는 renew되지 않음

– Delegated voms aware proxy after downloading it from both myproxy.cern.ch and the ALICE VOMS server

– Placed into the VOBOX at /opt/vobox/<vo_name>/proxy-repository

․ Proxy used to maintain the experiment services and submit the job agents □ 프록시 체크사항 : 호스트

○ Host proxy는 /opt/vobox/<vo_name>/renewal-proxy.pem 에 있음 – You can check its status (as user):

․ grid-proxy-info -f /opt/vobox/<vo_name>/renewal-proxy.pem – Who creates this proxy?:

․ /etc/rc.d/init.d/<vo_name>-bin-proxyrenewal.pem – Why is this proxy needed?:

․ Establish a secure communication myproxy server vs. VOBOX

․ 그렇지 않으면, myproxy 서버는 VOBOX에게 더 이상 갱신된 프록시를 제공하지 않음

신규 버전 및 활용법

(5) VOBOX

□ gLite3.1 VOBOX ○ 2008년 초 발표○ gLite3.0 VOBOX와는 달리 voms-aware함

– WMS, CREAM-CE등과 같은 서비스는 voms-aware 프록시를 활용함 ○ voms-aware한 proxy renewal을 지원

○ gridftp 서버 기능 제거 □ VOBOX Usage ○ VOBOX 내의 ALICE 서비스 관리하고자 한다면 ? ○ gLite-UI를 통해 로그인 – CERN의 myproxy 서버에 사용자의 프록시가 업로드 되어 있어야 함 $ myproxy-info -s myproxy.cern.ch -d – 만약 그렇지 않다면 업로드 한다, . ․ -t : ALICE에서는 48시간을 요구한다.

․ -c : 사용자 선택사항으로 기본값은 일이다7 .

$ myproxy-init -s myproxy.cern.ch -d -n -t 48 -c 900

– voms-aware proxy를 생성한다.

$ voms-proxy-init --voms alice:/alice/Role=lcgadmin

– ※ 반드시, voms-proxy-init전에 myproxy 서버에 유저프록시를 업로드 한다. – gsissh를 통해 VOBOX에 로그인

$ gsissh -p 1975 <vobox name>

○ VOBOX에 사용자의 프록시 등록

$ vobox-proxy --vo alice --voms alice:/alice/Role=lcgadmin register Registration was successfull:

DN: /DC=ch/DC=cern/OU=Organic Units/OU=Users/CN=pmendez/CN=477458/CN=Patricia Mendez Lorenzo/CN=proxy/CN=proxy/CN=proxy/CN=proxy File: /opt/vobox/alice/proxy_repository/+2fDC+3dch+2fDC+3dcern+2fOU+3dOrganic+20U nits+2fOU+3dUsers+2fCN+3dpmendez+2fCN+3d477458+2fCN+3dPatricia+20Mendez+20L orenzo+2fCN+3dproxy-voms+20alice+3a+2falice+2fRole+3dlcgadmin

Proxy Expiration Trigger (seconds): 0 Myproxy Expiration Trigger (seconds): 0 Email Address: N/A

Voms Extension: -voms alice:/alice/Role=lcgadmin

– ==> 이제 VOBOX는 프록시를 통해 유저를 인식한다.

․ VOBOX가 사용자의 프록시를 설정된 시간마다 renew한다. – 유저의 delegated proxy 위치

(7) Special Issue :: Pool Accounts

□ VOBOX는 pool account로 설정을 할 수 없음

○ 모든 sgm 멤버들은 단 하나의 unique local account에 매핑 됨 □ 예

○ VOBOX의 파일들은 root가 아니라 user 어카운트 소유이다.

$ cd /opt/vobox/alice/

rwx--- 2 alicesgm alicesgm 4096 Mar 26 14:57 stop drwx--- 2 alicesgm alicesgm 4096 Mar 26 14:57 start

drwx--- 2 alicesgm alicesgm 4096 Mar 26 14:57 info-provider drwx--- 2 alicesgm alicesgm 4096 Mar 26 14:57 agents

drwx--- 2 alicesgm alicesgm 4096 May 1 04:02 log

drwx--- 2 alicesgm alicesgm 4096 May 18 15:05 proxy_repository -r--- 1 alicesgm alicesgm 3121 May 21 14:20 renewal-proxy.pem drwxr-xr-x 8 alicesgm alicesgm 4096 May 21 14:20 .

-rw--- 1 alicesgm alicesgm 12288 May 21 16:39 _registerer_proxies.db

○ 만약 다른 유저가 다른 로컬 어카운트 예를 들어( , alicesgm03)로 매핑된다면, 의 등록은 이루어지지 않을 것이다 user proxy .

3. gLite-WMS

컴퓨팅에서의

(1) ALICE

gLite-WMS

□ 2008년 11월부터 ALICE 에서는 이전 버전인 LCG-RB를 퇴역시키고 있음 □ 모든 ALICE 사이트들은 프로덕션 레벨에서 WMS를 사용하고 있음 □ 각 사이트마다 최대 3개의 WMS를 정의해 두었음 ○ AliEn LDAP 설정 ○ CERN의 WMS는 대부분의 T2 사이트에서 백업 용도로 설정되어 있음 프랑스 및 이탈리아 제외 ( ) □ 로컬 WMS 설정은 사용되지 않음 ○ /opt/glite/etc/alice에 설정을 해 두었더라도 일단은 사용되지 않음활용

(2) gLite-WMS

□ gLite-WMS는 기본적으로 voms-aware하며 voms-aware한 프록시를 사용한다. ○ 따라서 새로운, gLite3.1 VOBOX들은 voms-aware하게 개발되었다.

□ ALICE는 AliEn LDAP 설정을 통해 각 사이트마다 WMS 리스트를 정의해 두었 다.

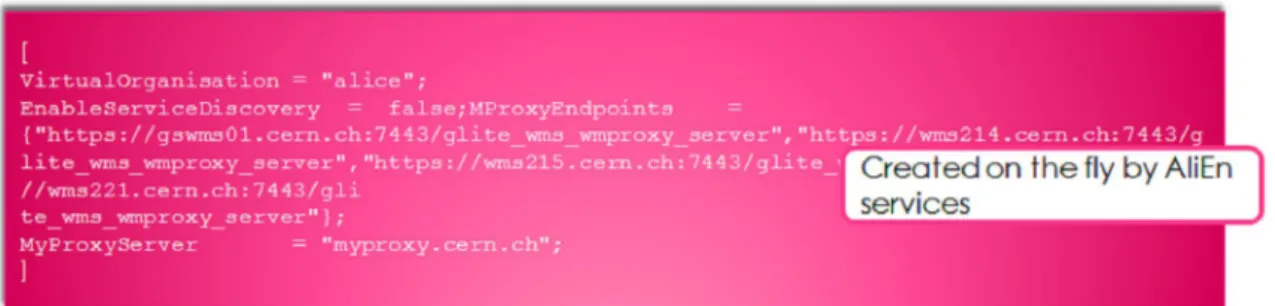

그림 2 AliEn LDAP에 등록된 gLite-WMS 리스트

(3) WMS

□ Job Agent는 로컬 VOBOX를 통해 submit 된다. □ 각 VOBOX에서 WMS가 정의되어 있다.

○ $HOME/alien-logs ○ 예: voalice06.cern.ch

그림 3 WMS를 활용한 Job Submission 스크립트

를 통한

의

(4) WMS

ALICE

Job Submission

□ Agent가 submission되는 동안, AliEn은 매 시간마다 user proxy를 renew한다. ○ $HOME/.alien/Environment에 있는 user proxy만 해당된다.

○ gLite-VOBOX 미들웨어와 동일한 프로시저를 따른다. ○ proxy의 lifetime은 적어도 47시간 이상이어야 한다. □ WMS의 proxy renewal mechanism은 사용되지 않는다.

○ ALICE 자체적으로 CERN 보안팀과의 협상을 통해, voms extension을 48시간 으로 조절했으며 이는 대부분의 production 및 analysis에 충분한 시간이다. ○ 물론, myproxy server로부터 delegate된 proxy의 lifetime은 사용자에 의해 설정

될 수 있다.

$ myproxy-init -s myproxy.cern.ch -d -n -t 48 -c 900

○ renew된 proxy는 다음과 같은 디렉토리에 위치한다.

$ ls /opt/vobox/alice/proxy-repository

□ "-d" 옵션을 이용한 Job Agent Submission

$ glite-wms-job-submit -d string_name -c $HOME/alien-logs/\

gswms01.cern.ch_wms214.cern.ch_wms215.cern.ch_wms221.cern.ch.vo.conf

○ “string_name"은 각 사이트마다 AliEn LDAP에 등록되어 있으며 "-d" 옵션을 사용할 경우 필수적으로 입력해야 한다.

배치 현황

(5)

□ CERN내에 ALICE 전용으로 대의4 WMS가 배치되어 있다. □ 프랑스에서는 ALICE에 사용되는 gLite3.2 버전의 WMS가 설치되어 있다. □ CNAF(이탈리아) T1에서는 ALICE에서 사용하는 WMS를 업그레이드 했다. □ ALICE실험을 위해 충분한 수의 WMS가 배치되었으며 정확한 서비스 모니터링이 이루어진다면 production에서의 ALICE WMS의 성공을 보장할 수 있을 것이다.(5) Problems and Solutions

4.

CREAM-CE

와

ALICE

컴퓨팅

개요

(1)

□ ALICE는 점차적으로 CREAM-CE를 모든 사이트에 설치할 계획이다. ○ VOBOX에서 직접 CREAM-CE에 Job을 submit

○ WMS를 거치지 않도록 할 계획

□ 2008년 여름부터 CREAM-CE를 사용하기 시작하였다.

□ 실제 데이터 획득(Real Data Taking)하기 전까지는 LCG-CE와 CREAM-CE를 병행 할 계획임

관련

입장

□ 2008년 11월, WLCG GDB 미팅에서의 ○ CREAM-CE 관련 현황

– ICE를 통한 CREAM에의 WMS job submission은 아직 불가능 – proxy renewal mechanism은 아직 최적화되지 않음 현재는 해결됨( )

○ ATLAS와 CMS 실험에서는 이러한 상기( ) 요인 때문에, 프로덕션 레벨에서 를 사용할 수 없었으나 테스트 중 와 에서는 가능했 CREAM-CE ( ), ALICE LHCb 음 – LHCb의 최우선 사항은 glexec와 SLC5였음 – ALICE에서 가장 먼저 가장 중요한 사항으로, CREAM을 다룸 ○ WLCG는 사이트들로 하여금 LCG-CE와 함께 CREAM-CE를 동시에 지원하기 를 원하고 있음

실험을 위한

요구사항 및 설치

(3) ALICE

CREAM-CE

□ ALICE에서의 각 사이트에 대한 요구 사항 ○ CREAM-CE를 위한 별도의 VOBOX 설치– 각 ALICE VOBOX는 특정 클러스터에 job을 submit함

– VOBOX 1개 보유 사이트 ==> 점차적으로 CREAM-CE로 이전 – VOBOX 2개 보유 사이트 ==> LCG-CE와 CREAM-CE 병행 ○ CREAM-CE에 ALICE production queue 설치

– ==> 새로 설치된 CREAM-CE가 곧바로 production에 돌입하게 됨 ○ gridftp 서버 설치 – job의 실행결과 (output)을 처리하기 위함 – 이 서비스는 필수사항은 아님 ․ CREAM-CE를 위한 VOBOX가 가장 좋은 방법임 □ CREAM-CE를 위한 VOBOX의 설정 ○ 이 새로운 VOBOX는 기존의 VOBOX와 거의 독립적으로 동작함 – packman을 제외한 모든 하위 서비스가 독립적으로 동작함 – 따라서, 2개의 VOBOX는 동일한 소프트웨어 영역을 공유해야 함 – ==> 1개의 VOBOX만 AliEn을 설치

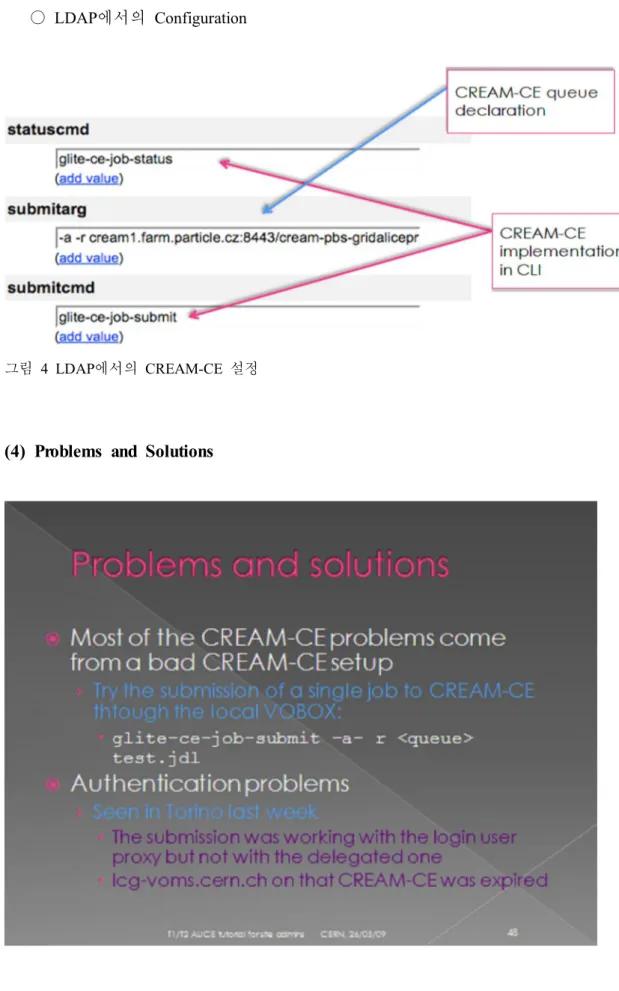

○ LDAP에서의 Configuration

그림 4 LDAP에서의 CREAM-CE 설정

5.

CREAM-CE

에서의

ALICE

실험

□ 2008년 여름, FZK(T1, 독일 에서 수행됨) (1st test phase of the CREAM-CE)

□ CREAM-CE를 위한 독립적인 VOBOX에서 테스트가 진행되었으며 WMS를 이용 해서 job submission이 이루어짐 □ 내부 CREAM-CE에 대한 접근은 Certified 인프라가 아닌 PPS 인프라에서 이루어 짐 ○ ※ PPS는 Certify 되기 직전의 인프라로서 새로운 소프트웨어 및 미들웨어의 최정 릴리즈 직전 상태에서 미리 설치된 인프라를 의미함 ○ 30 CPU ○ 3주 가량 후에 production 으로 이어짐 □ 2008년 7-9월 동안 기능 및 안정성에 대한 테스트가 이루어짐 ○ ALICE CREAM 모듈을 AliEn에 포함시키고자 Production이 멈춤 □ 결과 – 55,000개의 job이 성공적으로 수행됨 – 테스트 기간 동안 관리자가 개입할 필요가 전혀 없었음 □ CREAM-CE를 활용한 ALICE실험 정리 ○ AliEn 환경에 대한 CREAM-CE의 완벽한 구현이 이루어짐 ○ 2009년 1월에 이루어진 CREAM 모듈의 디버깅 이후 새로운, CREAM 모듈은 월 일에 프로덕션 사이트에 배치되기 시작함 2 19 (2nd test phase of CREAM-CE) – ○ 안정성 및 성능은 현재 각 사이트에서 이루어지고 있는 CREAM-CE 테스트의 가장 중요한 부분임 ○ 현재 12개의 사이트가 CREAM-CE를 지원하고 있음

– CERN, KISTI, INFN-Torino, CNAF, RAL, FZK, Kolkata, IHEP, SARA, Subatech, GSI, Athens

컴퓨팅 관련 주요 데이터 팜 현황 분석

ALICE

Ⅱ

1. SUBATECH

□ 사이트 개요 ○ 프랑스 IN2P3라는 물리학 연구기관의 20개 하위 조직중의 하나 – 프랑스 Britanny, Nantes에 위치 그림 5 SubaTech 위치 ○ 인원 : 150명 (IT 인력 5명) □ 프랑스 내 LCG 및 ALICE 사이트 현황 ○ CC-IN2P3 (T1 + T2 + Analysis Farm) ○ Clermont○ GRIF (IRFU, IPNO) ○ Nantes SUBATECH ○ Strasbourg IRES ○ Lyon IPNL ○ Grenoble LPSC

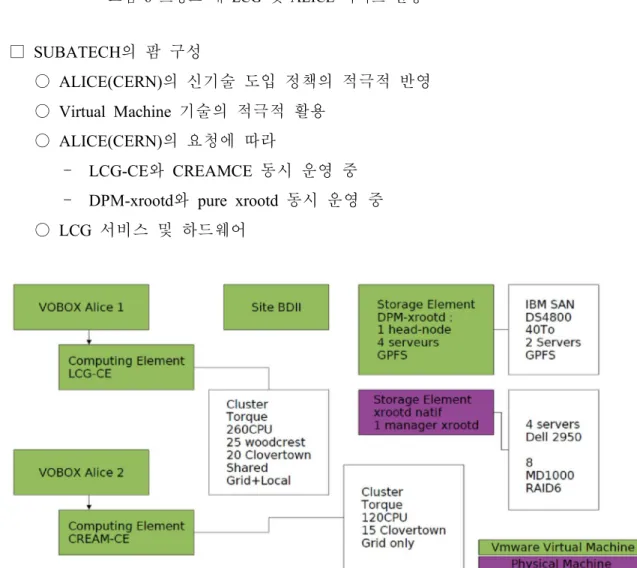

그림 6 프랑스 내 LCG 및 ALICE 사이트 현황 □ SUBATECH의 팜 구성 ○ ALICE(CERN)의 신기술 도입 정책의 적극적 반영 ○ Virtual Machine 기술의 적극적 활용 ○ ALICE(CERN)의 요청에 따라 – LCG-CE와 CREAMCE 동시 운영 중 – DPM-xrootd와 pure xrootd 동시 운영 중 ○ LCG 서비스 및 하드웨어

그림 7 SubaTech의 LCG 서비스 및 하드웨어

○ 네트워크

– Firewall/Virus scanner/IDS – Core Router 그림 8 SubaTech의 네트워크 구성 □ 구축 레포트 분석 ○ DPM-xrootd – DPM + xrootd는 아직 안정적이지 못함

․ xrootd 사용 가용량이/ GIP 및 MonaLisa에 제대로 리포팅 되지 않음 – xrootd 데몬의 원인 모를 정체 및 MySQL 데몬의 높은 부하 전체 성능 저하 발생 ==> ○ Native xrootd – ALICE (CERN) 권장 – 단순하고 쉬운 설치 및 운영 – EGEE/LCG에서는 아직 인식되지 않으나 잘 동작하고 있음 ○ CREAM-CE – LCG-CE에 비해 상대적으로 설치가 쉬움 (YUM) ․ BLAH 서버를 별도로 뽑아 설치해야 함 ․ APEL을 지원하기 위해 별도로 설정해주어야 함 – 최근 gLite에 포함되었으며 약간의 버그와 Tomcat관련 명확하지 않은 정보들이 산재함

– SAM에서 아직 테스트되지 않으므로 Site Availability를 위해서는 를 그대로 유지해야 함

– Job Submission에 사용되는 job profile은 LCG-CE와 동일 ○ AliEn Torrent – 성공적으로 테스트되었으나 약간의 수정이 필요함 ․ P2P에서 사용되는 6881포트를 이용하므로 방화벽과의 충돌이 우려도미 ○ 계획 – SL5로 이전 준비 중 – 네트워크 연결을 1Gbps에서 10Gbps로 업그레이드 계획 중 – PROOF 팜 준비 중 – DPM-xrootd 스토리지 제거 □ 참조 ○ SUBATECH : http://www-subatech.in2p3.fr/ ○ IN2P3 : http://www.in2p3.fr/ ○ LCG-FR : http://lcg.in2p3.fr/ ○ Nagios : http://www.nagios.org/ ○ Elog : https://midas.psi.ch/elog/ ○ Quattor : http://quattor.org/

2. TORINO

□ 자원 현황 ○ 계산 자원– 24 dual Xeon LV 2.0GHz 4GB (96 cores) – 10 dual Xeon E5450 16GB (80 cores) – 20 dual Xeon E5420 16GB (160 cores) – 4 dual Xeon E5345 8-16GB (32 cores)

․ Virtual machines: VAF prototype – Some old dual Xeon –2 or less GB

․ About 40 cores, not all online ○ Services:

– LCG CE and PBS server (torque+maui) accessible via WMS – CREAM CE accessible via CREAM VO-Box

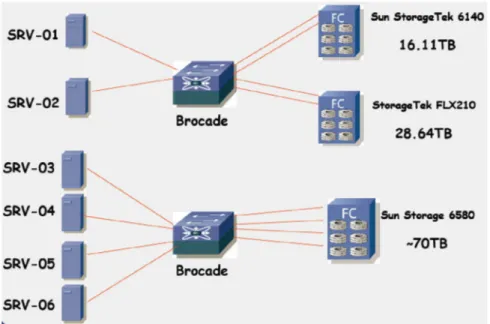

○ 스토리지 서비스를 위한 SAN(Storage Area Network) 구성

그림 9 Torino의 SAN 구성

○ 기타 서비스 – 2 VO-Boxes

– "Generic" DPM for other VOs – Separate site BDII (for performance) – Site + 2nd level HLR for accounting – User Interface

– Fabric monitoring server

․ Zabbix + Sun StorageTek tools, MRTG, §… – NAT & installation server (Cobbler + Puppet) □ 자원 운영 일간 스케쥴

○ 오전 1차 확인 사항 – MonALISA toolbar

– MonALISA services dashboard – Xrootd services (on servers) – Scan e-mail for ML messages

그림 10 Torino Tier2

○ 오전 2차 확인 사항 – ML Running profile

– VO-Box logs

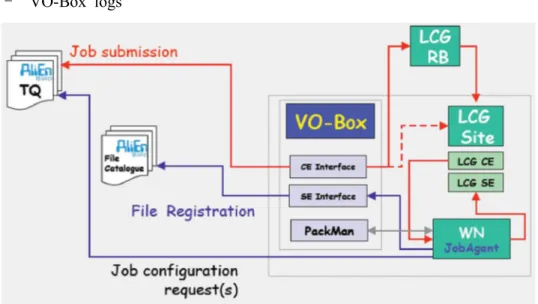

그림 12 VOBOX의 로그 파일 분석

․ All Service Logs : /home/alicesgm/alien-logs on the VO-Box ․ JobAgent log (often) : /home/alicesgm/alien-logs/proc

․ Stdin/stdout (if it worked...) : /proc/<username> on AliEn

․ Check stdin/stdout after registerOutput : Only for ERROR_V and (sometimes) ERROR_E

․ gLite Command Logs : /tmp/ALICE/tmp/… ․ LCG Job logs

– SAM tests & other LCG monitoring tools – Scan e-mail for Latchezar’ messages

․ ALICE(CERN)측 관점에서 모니터링 후 문제 발견 시 통지 □ 필수 확인사항 : 사이트 동작 여부 (MonaLisa에서 적색 또는 황색) – VO-Box 서비스 상태 확인 – 사용중인 WMS 및 연결상태 확인 – 프락시 확인 – UI (VO-Box) 확인 ○ VOBOX 상태 확인 절차 – 프락시 상태 확인

$ vobox-proxy --vo alice -- dn all query >> ■ Re-register dead proxy

>> ■ Cleanup DB and re-register dead proxy

>> ■ Check the LCG/CREAM CE status with local tools (qstat, pbsnodes,… or lcginfosites

– job submission 상태 확인

$ tail -1000f ~/alien-logs/CE.log >> ■ Is it submitting?

>> ■ Check the submitted JDL

>> ■ Check the status of a submitted LCG job

– ClusterMonitor 확인

$ tail -1000f ~/alien-logs/ClusterMonitor.log >> ■ From aliensh, ps -trace a few jobs

$ tail -1000f ~/alien-logs/ClusterMonitor.wakesup.log >> ■ I always forget this one…›

○ 서비스가 중단 시, ML이 재시작 시켰어야 한다 그렇지 않을 경우. :

$VO_ALICE_SW_DIR/alien/scripts/lcg/lcgAlien.sh [Stop|Start]<Service> >> ■ May not work: Stop does not kill the service

>> ■ You may end up with 5 different CEs submitting in parallel, usually making a mess

$ ps –x | grep CE; kill -9 … then alien StartCE

$ $VO_ALICE_SW_DIR/alien/etc/rc.d/init.d/aliend restart >> May not work (same reason)

$ ps –x | grep alien; killall – -9 …then aliend start

○ 서비스 가동 중이나 CE.log에 에러가 있을 경우 – 프락시와 CREAM/LCG CE의 상태 재확인 – WMS 상태 확인 ․ ~/alien-logs/xxx.vo.conf ․ ~/alien-logs/lastGoodRb – JDL을 통해 직접 job submission을 시도해서 확인 ․ 모든 필요한 커멘드는 CE.log에 들어 있음 ○ PackMan도 반드시 체크

□ 필수 확인사항 : 사이트가 동작중이나 실행되는 작업 없음 (MonaLisa에서 황색) ○ 설정(configuration) 확인

– The LDAP Database

․ ldap://aliendb06a.cern.ch:8389 ․ DN o=alice,dc=cern,dc=ch

․ http://alien.cern.ch/twiki/bin/view/AliEn/VOBoxConfigurationReference – Local configuration file

․ On the VO-Box: ~alicesgm/.alien/alice.conf

․ Used only for tests & debugging if localconfig=“dd”or “overwrite”å – Environment files ․ ${ALIEN_HOME}/.Environment ․ ~/.alien/Environment ○ 프락시 확인 상기 방법과 동일( ) ○ 빈번한 문제들 – Worker Node들이 커널 패닉 상태에 빠진 경우 – "aliroot" 프로세스의 오동작 로그에서 확인 가능( ) ․ AFS에서 문제가 발생한 경우 많음 ․ 타 실험지원시 사용했던 AFS에 의해 ․ AFS 제거를 통해 문제 해결 그림 13 Monalisa에서의 스토리지 서비스 상태

□ 필수 확인사항 : 작업이 실행되고 있으나 특정 에러 상태로 종료됨 (MonaLisa에 서 초록색) ○ 스토리지 확인 ○ 스토리지 컴포넌트 ○ DPM-xrootd에서 일반적으로 나타날 수 있는 오류들 그림 14 DPM-xrootd의 구성 – 서버 프로세스 (xrd)가 충돌이 나지 않은 상태에서 행(hang)되어 있음 ․ /var/log/xroot/server/xrdlog ․ /var/log/xroot/server/olblog ․ /var/log/xroot/manager/xrdlog ․ /var/log/xroot/manager/olblog – SE가 정상적으로 동작하고 기본 테스트는 통과하고 있으나 일부 파일들의 접근이 불가능할 때 ․ 서비스 재시작 ․ Cron job의 마지막 로그의 타임스탬프 확인 – 전체 파일시스템에 대한 쓰기(Write) 실패 ․ 에러는 xroot로 전이되지는 않음 ․ 스토리지에 크기가 ‘0’인 파일(zero-size file)이 생성됨

․ 전체 파일시스템이 읽기전용(readonly)로..

[root@grid008 ~]# /opt/lcg/bin/dpm-qryconf

POOL alice-to-test DEFSIZE 1000.00M GC_START_THRESH 0 GC_STOP_THRESH 0 DEF_LIFETIME 7.0d DEFPINTIME 2.0h MAX_LIFETIME 1.0m MAXPINTIME 12.0h FSS_POLICY maxfreespace GC_POLICY lru RS_POLICY fifo GIDS 0 S_TYPE -MIG_POLICY

none RET_POLICY R

CAPACITY 28.60T FREE 3.92T ( 13.7%)

t2-se-01.to.infn.it /disk00/dpm-alice-test CAPACITY 1.79T FREE 0 ( 0.0%) RDONLY

t2-se-01.to.infn.it /disk01/dpm-alice-test CAPACITY 1.79T FREE 0 ( 0.0%) RDONLY

t2-se-01.to.infn.it /disk02/dpm-alice-test CAPACITY 1.79T FREE 7.55G ( 0.4%) RDONLY

[…

t2-se-02.to.infn.it /disk00/dpm-alice-test CAPACITY 1.79T FREE 222.05G ( 12.1%)

t2-se-02.to.infn.it /disk01/dpm-alice-test CAPACITY 1.79T FREE 252.43G ( 13.8%)

로컬 서비스

AliEn

Ⅲ

1. AliEn Model

□ Job Execution Model

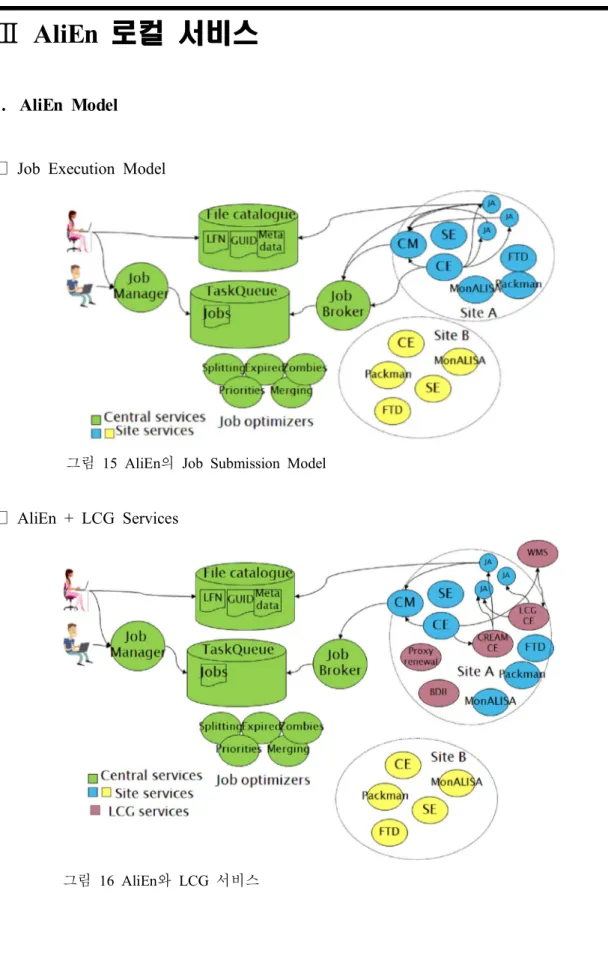

그림 15 AliEn의 Job Submission Model

□ AliEn + LCG Services

2. AliEn Installation

□ 설치 절차 $ wget http://alien.cern.ch/alien-auto-installer $ chmod +x ./alien-auto-installer $ ./alien-auto-installer ○ One-stop 자동 설치 기능 제공 ○ 최신 버전이 이미 설치되어 있는지 확인 필요 ○ 다수의 버전을 동시에 설치해 둘 수 있음 ○ Torrent를 이용한 설치도 가능 http://alien.cern.ch/alient-torrent-installer □ 설치 예 그림 17 AliEn 설치 예□ 업데이트 ○ 중앙관리 방식으로 업데이트가 이루어짐 ○ 요구사항 – MonaLisa 가 이미 동작하고 있어야 함 – 소프트웨어 영역에 쓰기 권한이 주어져 있어야 함 – 충분한 디스크 공간 확보 ○ 버전 확인 – 커멘드 라인 명령어 활용 $ alien -version – 다음 사이트 방문 http://pcalimonitor.cern.ch/stats?page=services_status 그림 18 MonALISA에서의 AliEn 상태

3. AliEn Site Services

개요

(1)

○ VOBOX 내에 다음 컴포넌트들이 존재 – ClusterMonitor (CM) / Packman / CE / SE / FTD – MonaLisa○ Worker node에는 JobAgent (JA)가 submit되어 동작함

그림 19 VOBOX 내 컴포넌트 들

(2) Local Configuration Files

○ $ALIEN_ROOT/.Environment (bash script)

– 변수 : ALIEN_ROOT, GLOBUS_LOCATION, PATH, LD_LIBRARY_PATH, …

○ $HOME/.alien/Environment (bash script)

– 변수 : ALIEN_USER, ALIEN_DOMAIN, … ○ $HOME/.alien/<vo>.conf

– 디버깅 중에는 특정 호스트에서만 허용됨 – Central LDAP에서 정의된 항목들을 수정 – http conf syntax

(3) X509 Authentication & Roles

○ X509_USER_PROXY가 올바른 proxy를 참조하고 있어야 한다.

○ 일반적으로 $HOME/.alien/glbus 디렉토리에 usercert.pem, userkey.pem이 있음

$ chmod 700 userkey.pem $ alien proxy-init

□ AliEn Users vs. AliEn roles

○ 모든 ALICE 유저들은 LDAP에 등록되어 있음

○ 사이트 관리자들은 다음 명령을 통해 production유저(aliprod)로 활동할 수 있음

$ alien -role aliprod

그림 20 ALICE LDAP에 등록된 ALICE사용자

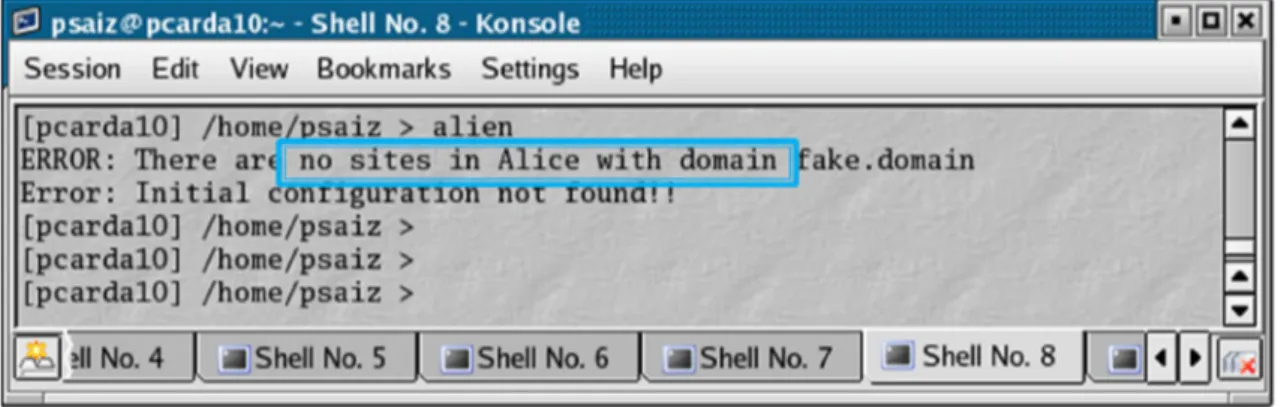

□ Possible Errors

○ Solutions:

– VO admin (Latchezar)에게 사이트의 상세 정보를 전달해 줘야 한다.

$ export ALIEN_DOMAIN=<existing domain>

그림 22 AliEn 로그인 에러 사례 프록시 없음 에러) ○ Solutions: – X509_USER_PROXY가 올바른 proxy를 가리키고 있는지 확인 $ alien proxy-init 그림 23 AliEn 로그인 에러 사례 사용자가) LDAP에 등록되지 않음으로써 발생하는 에러 ○ Solutions:

– VO 관리자가 유저의 이름을 LDAP의 production user로 추가해야 한다. ․ 약 10분 정도 시간이 지나야 효력을 발휘함

○ 정상적인 경우 그림 24 AliEn 로그인 에러 사례 정상적인 로그인) – 참고 : http://alien.cern.ch/twiki/bin/view/AliEn/HowToUseAliEn ․ alien catalogue 내에서의 동작을 확인할 수 있다. □ 서비스의 시작 및 종료 – 2가지 방법이 있다. – 수동 : alien (Start|Stop|Status)<service> – 자동 : aliend start|stop|status ․ MonaLisark 자동으로 다른 서비스를 재시작 시켜준다. – 로그 파일 확인 $ $LOGDIR/<Service>.log

4.

aliend

설정 및 가동

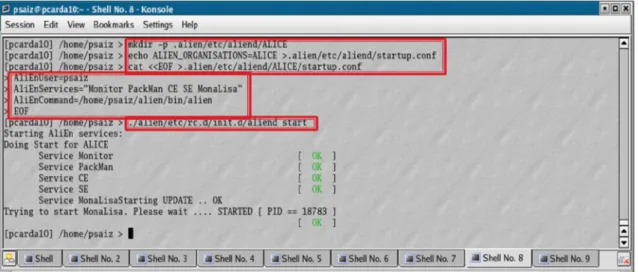

□ aliend setup ○ Create $HOME/.alien/etc/aliend/startup.conf $ cat ~/.alien/etc/aliend/startup.conf *** ALIEN_ORGANISATIONS=“ALICE” *** ○ Create $HOME/.alien/etc/aliend/ALICE/startup.conf$ cat ~/.alien/etc/aliend/startup.conf ***

AliEnUser=psaiz

AliEnCommand=“$HOME/alien/bin/alien“

AliEnServices=“MonaLisa CE SE PackMan Monitor" ***

□ 서비스 시작

그림 25 AliEn 로컬 서비스 시작

□ 로그 파일 확인 사항

□ Possible Errors

그림 27 AliEn 서비스 에러 사례) Packman 포트 중복

○ Solution:

– 해당 포트를 통해 Listening하고 있는 모든 프로세스를 중지한다.

$ kill -9 `ps –ef |grep PackMan |awk ‘{print $2}’`

AliEn Site Services' detail

Ⅳ

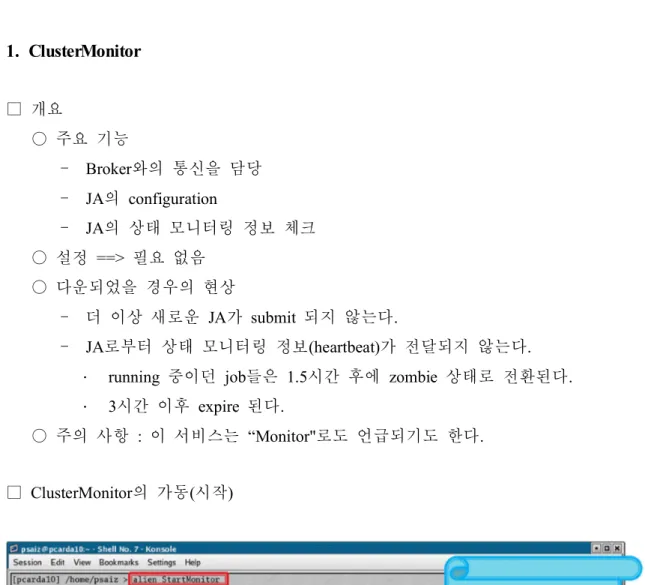

1. ClusterMonitor

□ 개요 ○ 주요 기능 – Broker와의 통신을 담당 – JA의 configuration – JA의 상태 모니터링 정보 체크 ○ 설정 ==> 필요 없음 ○ 다운되었을 경우의 현상 – 더 이상 새로운 JA가 submit 되지 않는다. – JA로부터 상태 모니터링 정보(heartbeat)가 전달되지 않는다. ․ running 중이던 job들은 1.5시간 후에 zombie 상태로 전환된다. ․ 3시간 이후 expire 된다.○ 주의 사항 : 이 서비스는 “Monitor"로도 언급되기도 한다.

□ ClusterMonitor의 가동 시작( )

2. PackMan

□ 개요 ○ 주요 기능 – 설치된 패키지 정보 제공 – 소프트웨어 패키지의 설치 제거 및 설정, ○ 설정 – Insalldir, platform ○ 다운되었을 경우의 현상 – CE는 더 이상 패키지 정보를 활용할 수 없다. – JA가 패키지를 설정하는데 문제가 발생한다. □ Possible Errors그림 29 AliEn 서비스 에러 사례) Packman의 LDAP 에러

○ Solution:

– LDAP configuration을 확인한다.

그림 30 PackMan의 가동 □ PackMan과의 통신 ○ 참고자료 : http://alien.cern.ch/twiki/bin/view/AliEn/HowToUsePackMan $ alien login ((alienshell)) packman ○ 패키지 리스팅 packman list packman listInstalled ○ 패키지 설치

packman install <package name>

○ 패키지 제거

packman remove <package name> or

rm -rf $HOME/.alien/packages/VO_ALICE/

3. CE

□ 개요

– JA의 submit

– 실제 서비스는 아님 ○ 설정

– Type, Maxjobs, Maxqueued, Cmds, args

그림 31 LDAP에 등록된 CE

○ 다운되었을 경우의 현상

□ Possible Errors

그림 32 AliEn 서비스 에러 사례) CE가 다운됨

그림 34 AliEn 서비스 에러 사례 큐 닫힘)

□ No Job matched your classad

$ top –status WAITING –user aliprod

$ jobListMatch <jobid> <ce_name> -verbose

그림 36 AliEn 서비스 에러 사례) ClassAd Mismatch #2

○ Possible Items – TTL : 프락시와 LDAP 설정의 확인 – Packages : PackMan이 동작하고 있는지 확인 – Partition : VO 관리자에게 사이트가 적합한 파티션을 가지고 있는지 문의 – SE : 다른 곳에서 실행되고 있으므로 신경쓸 필요 없음

4. Monalisa

□ 개요 ○ 다운되었을 경우 – 맵에 붉은 색으로 표시 – 사이트의 MonALISA 정보가 생성되지 않음– 다른 서비스의 자동 재시작이 불가능해짐

5. SE

□ 개요 ○ 기능 – 파일들의 유지 및 관리 – 파일의 즉각적인 전송 (mirror -i) – 링크가 없는 고립된 파일들의 제거 ○ 설정 정보– Type, directory, size

– IOdaemons(xrootd) host & port ○ 다운되었을 경우 – 파일 전송 불가능 ○ 다음 버전의 AliEn에서는 이 이름이 제거되고 다른 이름으로 등장할 예정임

6. FTD

□ 개요 ○ 기능 – 사이트간 데이터 전송 ○ 설정 정보– Protocols, X509 certificate, directories ○ 다운되었을 경우

– 사이트간 데이터 전송이 불가능해짐No scheduled transfers from or to the site

서비스 및

AliEn Central

Dashboard

Ⅴ

1. AliEn Central Services

(1) Hardware Overview and AliEn Services

□ Hardware Overview ○ ALICE 실험을 지원하는 전세계의 T0/T1/T2의 서비스들을 중앙에서 관리하고 이들 서비스들의 유지 및 개발을 진행한다. □ 27 machines □ Mix of SLC4, SLC5, Ubuntu 8.04, 8.10, 9.04 □ 100 cores □ 20 KVA UPSs □ 2 * 1Gbps uplinks 그림 37 AliEn 서비스를 위한 CERN의 하드웨어

○ AliEn Services

□ Several instances under a common DNS alias ○ Authen ○ Proxy ○ PackMan ○ Optimizers (Jobs, Transfers, Catalogue, PackMan )… ○ API servers 그림 38 AliEn 서비스와 이를 위한 하드웨어들

(2) DNS Load Balancing of Central Services

○ 각 사이트는 ML을 통해 CERN의 Central repository에 각 머신의 상태를 보고 함

– Operational status of each service (15분마다 확인) – Load on the machine, CPU, memory and swap utilization – 연결된 소켓의 수 ○ 위에서 열거된 파라미터를 이용해 점수가 매겨지고 CERN의 DNS alias가 활 용률이 상대적으로 낮은 머신들로 매분마다 업데이트 됨 ○ IP alias는 사용자 또는 사이트 서비스가 Central 서비스에 연결될 때 검색됨 – 이를 통해 활성상태의 머신들간의 로드밸런싱이 이루어지고, Central 서비스를 보호함

□ 실제 DNS Load Balancing 예

그림 39 DNS Load Balancing

Wed Jul 9 07:23:24 CEST 2008 : alice-proxy 137.138.99.136 137.138.99.137 137.138.99.141

Thu Jul 10 13:40:38 CEST 2008 : alice-proxy 137.138.99.137 137.138.99.141 Thu Jul 10 13:44:52 CEST 2008 : alice-proxy 137.138.99.136 137.138.99.137 137.138.99.141

(3) AliEn Central Services

□ Information Sources그림 40 AliEn Central Services -- Information Service

□ Build Servers

그림 41 AliEn Central Services -- Build Servers

그림 42 AliEn Central Services -- Monitoring

□ More Services

그림 43 AliEn Central Services -- Other Services

향후

(4)

Plan

□ 향후 도입되는 머신들, ○ 박스당 16코어의 머신 도입 – 전력 및 공간 절감 가능 – 가상화 기술(Virtualization Technology)의 적극적 활용을 통해 하드웨어의 수를 줄이고 관리의 편의성을 증대하는 방향으로 진행

2. ALICE Dashboard

(1) Dashboard Structure

□ Dashboard는 일종의 모니터링 또는 어카운팅 서비스로 볼 수 있으며 실험의 모든 모니터링 정보를 하나의 사이트에서 볼 수 있도록 구축한 ALICE 일종의 포털임 ○ 다른 실험에도 동일한 이름으로 동일한 목적을 위해 구축된 별도의 서비스들 이 존재함 □ Dashboard Framework○ Dashboard는 현재 Oracle DBMS를 사용하고 있고 DAO(Data Access Layer)를 통해 표준화된 방법으로 접근할 수 있도록 함으로써 가상화시켰으며 Web

를 통해 서비스가 제공되고 있음 Interface

그림 44 ALICE Dashboard Framework

그림 45 ALICE Dashboard Activities

3. Dashboard in Production

□ ALICE 실험의 Dashboard 첫페이지 ○ http://dashboard.cern.ch/alice 그림 46 ALICE Dashboard 첫 화면 □ Job Monitoring○ VO에 submit된 모든 작업을 확인할 수 있음 ○ 각 자원들로부터 정보를 수집함

– RGMA, IC Real Time Monitor, BDII, MonALISA, ... ○ VO 관리자 및 사이트 관리자 사용자들에게 매우 유용함, ○ 각기 다른 포맷으로 구성할 수 있음

– ALICE, ATLAS, CMS, LHCb and VleMed

그림 48 ALICE Dashboard Job 세부 뷰 □ FTS Reliability ○ 성공적인 데이터 전송에 대한 일별 리포트 ○ ALICE환경에 통합되어 있음 ○ ALICE 실험의 그동안의 여러 챌린지에서 성공적으로 활용되었음 – PDC06, PDC07, CRC08 ○ 현재 일반화시키는 작업이 진행되고 있으므로 향후 다른 실험에서 활용가능 함

□ SAM Monitoring

○ Service Availability Monitoring

○ Site Availability > Service Availability > Service Tests ○ 실제 LCG SAM 결과와 연결되어 있음

○ 원래 CMS에서 사용하려 개발하였으나 ATLAS 실험에서 유사한 인터페이스를 사용하기 시작했고 현재는 일반화 시키는 작업이 진행되고 있음

그림 51 ALICE Dashboard Site Availability

□ Site Status Board

○ CMS 지원 사이트들의 상태 테이블 ○ 새로운 메트릭스를 정의하기가 매우 쉬움 – 다양한 정보의 소스를 지정할 수 있음 ○ 링크를 클릭하면 보다 자세한 정보를 열람할 수 있음 ○ GridMap View 연결 ○ CMS에서 먼저 사용되었고 ALICE와 LHCb에서 사용하고 있음

MonALISA

Ⅵ

1. 개요

□ Caltech Project (2002), http://monalisa.caltech.edu □ 자바 기반의 Distributed, self-describing services

□ 정보의 형태와 무관하게 수집할 수 있도록 구성된 인프라를 제공함 □ 거의 실시간에 가깝게 수행함

□ 서비스간의 IO를 통해 모니터링이 이루어짐 □ 분산 에이전트를 수행하는 플랫폼으로도 활용가능

2.

MonALISA

소프트웨어 컴포넌트 및 컴포넌트간 연결

□ Single point failure 없는 완전한 분산 시스템을 구성함

□ Subscriber/notification paradigm

그림 54 Subscriber 및 notification paradigm

□ MonALISA 서비스 모듈 ○ 포함된 패키지

– Local host monitoring (CPU, memory, network traffic, processes, sockets, LM sensors, APC UPSs), log files

– SNMP generic & specific modules

– Condor, PBS, LSF and SGE (accounting & host monitoring), Ganglia – Ping, tracepath, traceroute, pathload and other network-related measurements – Ciena, Optical switches

– Calling external applications/scripts that return as output the values – XDR-formatted UDP messages (such as ApMon).

○ 간단한 자바 인터페이스만 구현하면 새로운 모듈도 쉽게 포함시킬 수 있음 ○ 데이터를 모으기 위한 필터도 쉽게 정의할 수 있음 ○ 수집된 모니터링 정보에 대한 자동화된 대응도 포함시킬 수 있음 ○ 분산 에이전트를 실행시킬 수도 있음 – VRVS와 EVO에서 Reflector간 연결 트리를 관리할 때 사용함 – 데이터 전송을 위해 특정 네트워크 단말간 Optical Path 설정에 사용함

□ APMON : Embeddable APlication MONitoring (APMON) Library

○ ApMon은 C, C++, Java, Perl, Python 등으로 구현된 라이브러리들의 조합으로 모니터링 정보를 전달하기 위한 매운 간편한 API를 제공하고 있음

○ Data Packing의 XDR open format을 기반으로 함

○ 모니터링될 어플리케이션에 대한 영향을 최소화하기 위해 UDP상에서 구현됨 ○ 어플리케이션이 특정값을 전송할 수 있는 채널을 제공하고 로컬 호스트 모니

터링 기능도 제공함

– AliEn에서는 Perl 버전을 사용하여 각 서비스와 JobAgent로부터 로컬 인스턴스로의 정보 전달이 이루어짐

MonALISA

– C/C++버전은 ROOT(TMonalisaWriter), Proof, Xrootd에서 사용됨 – CMS에서도 모든 Job에 대한 모니터링 정보를 전송하는데 사용함

○ 독자적으로 사용될 수 있는데 무한 반복하는 어플리케이션에서 기본 호스트, 모니터링 파라미터와 다른 관심 정보들을 전송하는데 사용될 수 있다.

□ Data Storage Model

○ MonALISA는 모니터링 히스토리를 관리하기 위해 메모리 버퍼를 사용함 ○ 뒷단에 데이터를 영구보관하기 위한 DBMS를 둘 수 있음 – 기본적으로 1주일간은 전체 데이터를 1개월간은 평균값을 보관함 – 클라이언트는 보통 3개의 스트럭쳐를 생성 ○ 성능과 확장성을 향상시키기 위해 뒷단에 병렬 DBMS를 사용할 수 있다. 그림 55 MonALISA의 데이터 모델

□ Clients

○ GUI Client

– Interactive exploring of all the parameters – Can plot history or real-time values – Customizable history query interval

– Subscribes to those particular series and updates the plots in real time ○ Storage client (aka Repository)

– Subscribes to a set of parameters and stores them in database structures suitable

for long-term archival

– Is usually complemented by a web interface presenting these values – Can also be embedded in another controlling application

○ WebServices clients

– Limited functionality: they lack the subscription mechanism

그림 56 MonALISA GUI Client

3. AliEn MonALISA

□ MonALISA 기반 AliEn 모니터링 ○ http://pcalimonitor.cern.ch

그림 57 MonALISA 기반 AliEn 모니터링 □ AliEn MonALISA 서비스 ○ 시작 $ alien StartMonaLisa ○ X509_USER_PROXY를 비롯하여 AliEn의 다른 서비스들과 동일한 환경에서 시작되어야 함 ○ 각 컴포넌트들로부터 정보를 수집하고 VOBOX내 AliEn서비스들의 동작을 테 스트하기도 함 ○ 필요한 경우 서비스들을 재시작 시키기도 하며 자기 자신은 크론(cron)을 통 해 주기적으로 모니터링되므로 crontab내의 해당라인을 제거하면 안됨 □ MonALISA에 의해 모니터링되는 ALICE 그리드 정보 ○ 85 sites defined ○ 9000 worker nodes ○ 14000 parallel jobs ○ 27 central machines

○ Storing only aggregated data where possible we have reached >35000 active parameters in the database

○ We store new values at ~100Hz ○ 15000 dynamic pages / day

○ 1 client/web server + 3 database instances ○ 170GB of history

○ http://pcalimonitor.cern.ch

□ Services > Site Services > Site Overview

그림 60 ALICE MonALISA -- Site Overview

□ Services > Site Services > VO Boxes

□ Services > Site Services > Service Status

그림 62 ALICE MonALISA -- VOBOX AliEn Service Status

□ Services > Site Services > Proxies

□ Services > Site Services > SAM tests

그림 64 ALICE MonALISA -- SAM Tests

□ SE Information > xrootd > SEs overview

□ SE Information > xrootd > Per SE Details

□ Bandwidth Tests

○ Bandwidth 테스트 결과와 함께 향상시킬 수 있는 방법에 대한 조언도 표시함

그림 67 ALICE MonALISA -- Bandwidth Test

4. Automatic Actions

□ ML에 의해 이루어지는 의사 판단 사항들 ○ Absence/presence of some parameter(s) ○ Values above/below predefined thresholds ○ Arbitrary correlations between values ○ User-defined code

□ Action Types ○ Notifications ○ RSS/Atom feeds

○ Annotation of charts with the events ○ Calling external programs

○ Logging

○ Running custom code

그림 68 ALICE MonALISA -- Automatic Action

□ ALICE에서의 Automatic Actions

○ VOBOX가 기능 테스트에 실패할 경우 서비스 재시작 – Only if central services are ok

– Send mail if the restart doesn't solve the problem – Try again every 12 hours

○ 중앙에서의 원격 사이트 스토리지 엘리먼트 테스트 – Notifications if tests fail

○ Central 서비스들의 DNS alias 관리 – Remove offline or overloaded services

– Automatically adding new service instances ○ MC Production jobs (LPM)

○ proxy, SAM tests, Central Services 등에 대한 Notification

○ Firefox Toolbar Expanded

그림 70 ALICE MonALISA -- Firefox Extension

5. Site Monitoring

□ Using a small ApMon daemon on each WN ○ Or SNMP, Ganglia …

□ Send data to the MonALISA service running on the VoBox

□ Run your own Repository to archive data, display it and implement your own automatic actions

□ GSI: http://lxgrid2.gsi.de:8080/

□ Muenster: http://gridikp.uni-muenster.de:8080/